Componentes detrás de las gafas inteligentes y de realidad aumentada de última generación

Las gafas están emergiendo como el nuevo factor de forma de dispositivo personal, fusionando moda, función y conectividad en un paquete elegante. Según IDC, se espera que los envíos de gafas inteligentes y de realidad aumentada (AR) crezcan un 39% en 2025, alcanzando los 14 millones de unidades y subiendo a 43 millones en 2029.

El mercado actualmente está siendo impulsado por las gafas inteligentes (también conocidas como gafas AI), con un crecimiento del 250% en 2025, sin embargo, las gafas AR de próxima generación están a la vuelta de la esquina. Desde las Ray-Bans habilitadas para cámara y AI de Meta hasta las gafas de visualización AR ligeras de XREAL, la categoría está avanzando hacia el uso diario para millones.

Conclusiones Clave

- Las gafas inteligentes y AR están acelerando hacia la adopción generalizada, con pronósticos de ingresos globales superando los $25–30 mil millones para 2030.

- Los avances en pantallas, sensores y sistemas de energía están impulsando la innovación en gafas inteligentes basadas en cámara y AI y la evolución hacia diseños AR ligeros con superposiciones visuales reales.

- Los avances de proveedores como Sony, Qualcomm, Bosch y Renesas están haciendo que las gafas sean más ligeras, cómodas y capaces, convirtiendo el uso de gafas en la próxima frontera de la tecnología personal.

La Tecnología Dentro del Marco

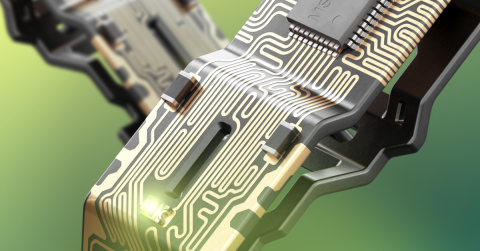

Impulsando este crecimiento hay una cascada de avances en componentes. Cámaras miniatura y micrófonos MEMS, pantallas micro-OLED, IMUs de precisión y baterías de alta densidad energética han sido diseñados para encajar dentro de un marco que no pesa más que un par de gafas elegantes de uso diario.

Cada nuevo producto representa un sofisticado equilibrio de óptica, térmicas, conectividad y estilo. El resultado son gafas que lucen familiares pero ofrecen el tipo de capacidades de computación que antes estaban reservadas para los smartphones potentes. Las gafas inteligentes y de realidad aumentada de hoy muestran cuán lejos ha llegado la innovación en componentes, y es fácil imaginar cuánto más puede y avanzará.

Las Gafas Inteligentes se Popularizan

La generación actual de gafas inteligentes favorece la comunicación, la asistencia por IA y la comodidad de manos libres sobre las visuales aumentadas. En lugar de proyectar gráficos, capturan imágenes y video, transmiten audio y se conectan a asistentes de IA en tiempo real. Dentro de esos marcos delgados hay una impresionante colección de partes.

Las gafas Ray-Ban Meta, por ejemplo, funcionan con el chipset Qualcomm Snapdragon AR1 Gen 1, que es un silicio personalizado optimizado para el procesamiento de cámaras compactas y conectividad de baja latencia. Además, estas gafas inteligentes líderes en el mercado utilizan una gama de componentes impresionantes:

- SoC + ISP: los procesadores de señal de imagen duales de AR1 manejan fotos de 12 MP y videos de 6 MP directamente en el dispositivo, minimizando el calor y la latencia.

- Subsistema de audio: micro-altavoces de oído abierto y formación de haces de micrófonos MEMS de Knowles – como el SPH1644LM4H1 – ofrecen llamadas claras y manos libres.

- Detección de movimiento: una IMU Bosch BMI270 rastrea el movimiento de la cabeza para estabilización y activación de gestos.

- Batería y medidor de combustible: una batería de Li-ion de celda única emparejada con el bq27441 de TI ofrece una predicción precisa del tiempo de funcionamiento.

Los diseñadores también han resuelto problemas clave de comodidad: distribución del peso, enfriamiento pasivo y canales acústicos transparentes. Estos avances han hecho que las gafas inteligentes sean ligeras, a la moda, funcionales y prácticas para usar en público.

Brindando Vida a la Vista: Pantallas y Óptica

Mientras que las gafas inteligentes basadas en cámaras y IA están entrando en el mainstream hoy en día, la próxima frontera es la augmentación visual – gafas AR que proyectan una imagen digital verdadera en tu campo de visión. Entre los dispositivos de consumo, las gafas XREAL One Pro AR se han convertido en un diseño de referencia para lo que es posible actualmente. Utilizan paneles micro-OLED de Sony de 0.55 pulgadas funcionando a 1080p/120 Hz, logrando un campo de visión de 57 grados con un contraste vívido y un brillo de hasta 700 nits. El motor óptico de prisma plano de la compañía pliega la luz de manera eficiente, permitiendo que se ajuste dentro de un marco delgado.

Las pantallas micro-OLED siguen siendo el caballo de batalla de las gafas AR modernas. Ofrecen colores ricos, excelente contraste y una salida térmica manejable, que son críticos para un dispositivo que se sitúa a milímetros de los ojos del usuario. Su desventaja es el brillo; a máxima intensidad, todavía luchan contra la luz solar directa.

Para superar ese límite y lograr funcionalidad al aire libre, los desarrolladores están recurriendo a la óptica de guía de onda. Estas son las capas transparentes que guían la luz que doblan las imágenes proyectadas hacia la vista del usuario. Dos enfoques principales dominan:

- Los guías de onda reflectivos (Lumus, SCHOTT) utilizan pequeños espejos para redirigir la luz con alta eficiencia, haciéndolos lo suficientemente brillantes para su uso al aire libre.

- Los guías de onda difractivos (Dispelix, DigiLens) usan rejillas nanoestructuradas para combinar luz roja, verde y azul en una única lámina delgada. El resultado son marcos ligeros y aerodinámicos.

Ambos tienen compensaciones. Los tipos reflectivos ofrecen brillo y bajo "brillo ocular" pero añaden unos pocos milímetros de grosor; los tipos difractivos son más delgados pero pueden perder uniformidad de color y eficiencia. Mientras tanto, los microdisplays de micro-LED – como el MicroLED AMμLED™ 0.13 Series MIPI microdisplay de JBD – prometen AR legible bajo la luz del sol una vez que la producción escale en 2026. Este microdisplay ofrece una extraordinaria densidad de 6,350 pixeles por pulgada (PPI), posicionándolo entre los microdisplays más pequeños y brillantes del mundo.

Computación y Detección: El Cerebro y los Ojos

A medida que las pantallas mejoran, la infraestructura de cómputo debe mantener el ritmo. Muchos sistemas AR de alta gama ahora dependen de los chipsets Qualcomm’s XR2 Gen 2 y XR2+ Gen 2, diseñados para manejar hasta diez cámaras concurrentes y mapeo espacial en tiempo real.

Alrededor de estos procesadores hay una creciente constelación de sensores:

- IMUs como el ST ISM330IS gestionan el seguimiento de movimiento y la estabilización.

- Sensores como Sony’s IMX560 SPAD ToF, en combinación con la iluminación ams-OSRAM VCSEL para la detección de profundidad, se utilizan para mapear el entorno.

- Cámaras y módulos de sensores de imagen como el 5 MP OmniVision OV716 CIS se encargan de la captura orientada al mundo, el seguimiento ocular y el reconocimiento de gestos.

Un solo par de gafas AR ahora puede integrar más de ocho sensores, todos alimentando un flujo de datos sincronizado que debe fusionarse en milisegundos. La latencia, no la velocidad de procesamiento bruto, determina cuán natural se siente la experiencia. Ese desafío ha impulsado a los proveedores de SoC a integrar centros de sensores dedicados y núcleos de IA, difuminando la línea entre computación y detección/percepción.

Potencia, Térmicas y Conectividad

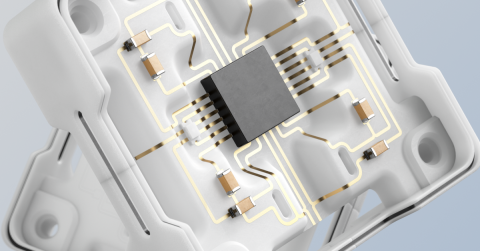

No importa cuán capaces sean las ópticas o los procesadores, la gestión de la energía aún dicta cuánto tiempo pueden funcionar estos dispositivos y qué tan cómodos se sienten. La mayoría de los diseños utilizan una batería de Li-ion de celda única dividida entre los dos brazos de la montura, conectados por una cinta flexible de PCB.

Para alejar el calor de la sien, los ingenieros confían en láminas de grafito Panasonic PGS y en almohadillas GraphiteTIM (como EYGS182307), que conducen el calor lateralmente a través del marco en lugar de permitir que se acumule cerca de la sien. La diferencia entre 38°C y 43°C en contacto con la piel es la diferencia entre usable e inusable.

Los módulos de conectividad añaden su propia complejidad. Los módulos Murata Type 2FY y 2EA combinan Wi-Fi 6/7 y Bluetooth LE en paquetes compactos y blindados. Los controladores complementarios, como los SoCs BLE Renesas DA1470x, gestionan las entradas de usuario, la activación por voz y los estados de energía sin despertar al procesador principal. Incluso la colocación de la antena es un cuidadoso equilibrio, compartiendo espacio con altavoces, micrófonos y aperturas de cámara en apenas unos pocos milímetros de plástico.

La Próxima Ola de AR Cotidiana

La línea entre las gafas inteligentes y las gafas de realidad aumentada (AR) está empezando a difuminarse. La producción de Guías de Onda Reflectivas Geométricas de SCHOTT se aceleró en 2025, y el reciente lanzamiento de las nuevas Ray-Bans con pantalla de Meta señalan que el AR para consumidores está casi listo para el horario estelar. Los primeros modelos enfatizarán datos consultables rápidamente, incluyendo subtítulos, navegación y notificaciones, en lugar de videos completos o superposiciones en 3D, manteniendo presupuestos de energía realistas.

A medida que la eficiencia óptica mejora y la química de las baterías avanza, las gafas ofrecerán un tiempo de uso más largo y una mejor legibilidad al aire libre sin sacrificar el diseño. Lo sorprendente es lo incrementales que son estos avances: difusores de grafito más delgados, microdisplays más brillantes y PMICs ligeramente más inteligentes.

Para los diseñadores de hardware, esta convergencia significa más trabajo interdisciplinario: ingenieros ópticos colaborando con equipos de diseño de PCB, desarrolladores de firmware ajustando perfiles de energía para el confort, gerentes de adquisiciones siguiendo proveedores de guías de onda como una vez siguieron a los GPUs.

Notas desde el Campo: Vistiendo el Futuro

Después de meses de uso regular, estos dispositivos se han convertido en parte de mi rutina diaria. Llevo mis gafas AI Meta Ray-Ban la mayoría de los días, caminando por la ciudad con un audiolibro o música reproduciéndose a través de altavoces de oído abierto. Sin auriculares atascados en mis oídos o visibles para otros, sin desconexión del mundo que me rodea. Cuando llega una alerta de WhatsApp, las gafas susurran el mensaje en mi oído, manos libres, mientras sigo enfocado en la calle adelante o en el tendero con el que estoy charlando. Cuando tengo una pregunta, la hago en voz baja, como si estuviera hablando conmigo mismo o con un amigo AI en mi cabeza, y obtengo una respuesta al instante. Se siente como el futuro.

Las gafas parecen monturas cotidianas elegantes, así que la gente no nota que estoy interactuando con tecnología, y se siente como si estuviera operando bajo el radar.

Cuando estoy en vuelos largos, cambio a mis gafas AR XREAL One Pro. Conectadas a mi teléfono o portátil a través de USB-C, muestran una vista de micro-OLED de pantalla grande justo frente a mí, así que, en lugar de sentirme como si estuviera en una cabina de avión estrecha, me siento como si estuviera en un cine grande y privado. Esto, junto con auriculares con cancelación de ruido, hace que un vuelo largo en clase económica sea mucho más soportable.

Estas experiencias personales subrayan el logro tecnológico central aquí: el hardware finalmente se ha vuelto pequeño, fresco y eficiente como para desaparecer en monturas cotidianas, convirtiendo lo que una vez requirió voluminosos auriculares en algo tan simple como ponerse unas gafas.

Un Nuevo Formato Que Parece Inevitable

Las gafas inteligentes y AR marcan la próxima fase de la computación personal: ambiental, manos libres e integrada de manera fluida en la vida cotidiana. En lugar de sacar un dispositivo para interactuar con la información, estamos viviendo junto a ella: haciendo preguntas en voz alta, recibiendo respuestas en nuestro oído, viendo el mundo aumentado en tiempo real. A medida que los componentes se vuelven más pequeños, inteligentes y eficientes, las gafas demuestran que la tecnología más poderosa es aquella que está presente cuando se necesita e invisible cuando no.

Ya sea que esté construyendo electrónica de potencia confiable o sistemas digitales avanzados para la próxima ola de dispositivos inteligentes y de realidad aumentada, Altium Develop reúne a todas las disciplinas en un entorno colaborativo, libre de silos y límites. Experimente Altium Develop hoy para ver cómo una plataforma unificada ayuda a ingenieros, diseñadores e innovadores a co-crear sin restricciones.