Czujniki obrazu wspomagane AI: Oczy, które nigdy się nie mrugają

Era aparatów służących tylko do robienia zdjęć jest już za nami. Wzmacniane AI sensory obrazowania teraz wyposażają maszyny w oczy, które nigdy się nie zamykają, nigdy się nie męczą i mogą widzieć poza ludzkimi możliwościami. Te sensory nie tylko rejestrują obrazy – poprzez integrację wysokiej rozdzielczości obrazowania z przetwarzaniem AI na chipie, rozumieją i interpretują je w czasie rzeczywistym.

Nowa era wizji maszynowej i percepcji

Wzmacniane AI sensory obrazu reprezentują zmianę paradygmatu w przetwarzaniu i wykorzystywaniu danych wizualnych. Interpretują dane wizualne z niezrównaną dokładnością i efektywnością, napędzając narzędzia takie jak rozpoznawanie obiektów w czasie rzeczywistym i analiza twarzy. Te sensory przetwarzają dane bezpośrednio na chipie, umożliwiając niemal natychmiastową analizę i podejmowanie decyzji.

Umożliwiają one przełomowe możliwości we wszystkim, od autonomicznych pojazdów nawigujących po skomplikowanych miejskich ulicach po systemy bezpieczeństwa zdolne do wykrywania przestępstw w momencie ich wystąpienia. W dziedzinach takich jak obrazowanie medyczne, wzmacniane AI sensory obrazowania zapewniają szczegółowe obrazy wysokiej rozdzielczości i precyzyjne wykrywanie, które mogą poprawić dokładność diagnozy. Pewnego dnia mogą nawet być w stanie wykryć nasze emocje.

Czujniki obrazu wspomagane sztuczną inteligencją mogą być łączone z innymi technologiami, takimi jak spektralne czujniki, aby zwiększyć funkcjonalność. Na przykład, integracja SI z elektrooptycznymi czujnikami umożliwia automatyczne rozpoznawanie celów i poprawia rozdzielczość obrazu.

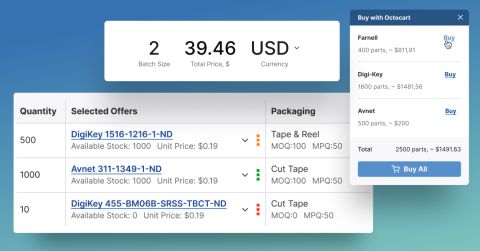

Skupmy nasze obiektywy na godnych uwagi czujnikach

Oto pięć czujników obrazu wspomaganych przez SI, które zasługują na Twoją uwagę:

- Samsung ISOCELL HP2: Te czujniki posiadają 200-megapikselową kamerę z zaawansowanymi podwójnymi bramkami i algorytmami uczenia głębokiego, zapewniając wyjątkową szczegółowość i kolor. Doskonale sprawdzają się w warunkach słabego oświetlenia, szybko ustawiając ostrość nawet w ciemności.

- Omnivision OX03C10: Ten czujnik obrazu dla motoryzacji klasy ASIL-C oferuje 140 dB HDR i najlepszą wydajność redukcji migotania LED oraz wbudowany silnik SI dla zaawansowanych systemów wspomagania kierowcy (ADAS).

- Canon Dual Pixel CMOS AF: Znane z technologii autofokusu z podwójnym pikselem, która jest wspomagana przez SI, aby poprawić dokładność i szybkość ustawiania ostrości, te czujniki wyróżniają się w cyfrowych aparatach fotograficznych i profesjonalnym sprzęcie wideo.

- Sony IMX500 Intelligent Vision: IMX500 posiada strukturę sensora typu stacked, która obejmuje sensor obrazu, potężny DSP oraz dedykowaną na chipie SRAM, umożliwiającą szybkie przetwarzanie AI na krawędzi.

- Prophesee Metavision®: Te inspirowane neuromorficznie sensory wizyjne oparte na zdarzeniach rejestrują tylko zmiany w scenie, zamiast pełnych klatek. Dostarcza to ultraniskiej latencji i ekstremalnej efektywności energetycznej dla robotyki i autonomicznych pojazdów.

Fala Postępu Technologicznego

Te sensory napędzają falę innowacji technologicznych, która wykracza poza samą tylko wizję. Umożliwiają nowe możliwości w architekturze systemów, przetwarzaniu sygnałów i obliczeniach na krawędzi. Wynikające z tego przełomy tworzą możliwości w różnych branżach, od urządzeń mobilnych po systemy autonomiczne.

Architektury 3D Stacked: Postępy są osiągane poprzez stosowanie wielu warstw w celu stworzenia architektur 3D. To podejście ma na celu zwiększenie wydajności bez zwiększania rozmiaru urządzenia, co jest niekończącym się celem dla kompaktowych aplikacji, takich jak smartfony i przenośne urządzenia medyczne. Architektury 3D stacked ułatwiają również integrację zaawansowanych funkcji – takich jak szybkie przechwytywanie obrazu, przetwarzanie AI na chipie i poprawiona efektywność energetyczna – tworząc możliwości dla aplikacji obrazowania nowej generacji.

Zaawansowane przetwarzanie sygnałów: Integracja zaawansowanego przetwarzania sygnałów pozwala tym czujnikom na wykonywanie skomplikowanych manipulacji i ulepszeń obrazu w locie. To podejście redukuje obciążenie procesowe na zewnętrznych urządzeniach i jest nieocenione w aplikacjach wymagających niskiej latencji lub obrazowania w czasie rzeczywistym, takich jak systemy bezpieczeństwa samochodowego.

Przetwarzanie AI na krawędzi: Te czujniki mogą wykonywać złożone analizy danych i zadania decyzyjne bezpośrednio na urządzeniu, dzięki włączeniu przetwarzania AI na krawędzi. Przetwarzanie na krawędzi może optymalizować efektywność energetyczną, redukować latencję i umożliwiać inteligentne filtrowanie danych.

Wyzwania techniczne

Chociaż czujniki obrazowania wzmocnione AI stanowią znaczący postęp w technologii wizji maszynowej, inżynierowie stają przed kilkoma wyzwaniami technicznymi, które muszą być brane pod uwagę podczas projektowania systemu, w tym:

Zużycie energii pozostaje głównym ograniczeniem: Integracja możliwości przetwarzania AI z tradycyjnymi funkcjami obrazowania znacząco zwiększa wymagania energetyczne czujnika. Może to prowadzić do wyzwań związanych z zarządzaniem ciepłem, szczególnie w kompaktowych urządzeniach, gdzie opcje rozpraszania ciepła są ograniczone. Na przykład, ciągłe przetwarzanie AI może powodować wzrost temperatury czujnika, potencjalnie wpływając na jakość obrazu i wymagając zaawansowanych technik zarządzania ciepłem.

Ograniczenia wydajności występują w różnych warunkach pracy i czynnikach środowiskowych: Te czujniki mogą mieć problemy w ekstremalnych warunkach oświetleniowych. Bardzo słabe oświetlenie może wprowadzać szum, który wpływa na dokładność przetwarzania przez AI, podczas gdy sceny o wysokim zakresie dynamiki mogą stanowić wyzwanie dla zdolności czujnika do utrzymania spójnej detekcji i klasyfikacji obiektów. Czynniki środowiskowe, takie jak wibracje, zakłócenia elektromagnetyczne i wahania temperatury, mogą również wpływać zarówno na możliwości obrazowania, jak i przetwarzania tych czujników.

Trudne kompromisy rozdzielczości i przetwarzania muszą zostać dokonane: Chociaż te czujniki mogą wykonywać imponujące analizy na chipie, muszą one równoważyć konkurencyjne wymagania jakości obrazu, szybkości przetwarzania i zużycia energii. Często prowadzi to do kompromisów – na przykład, osiągnięcie przetwarzania w czasie rzeczywistym może wymagać zmniejszenia rozdzielczości lub ograniczenia złożoności algorytmów AI.

Ograniczenia modeli AI stanowią kolejne wyzwanie: Dostępne na chipie zasoby obliczeniowe ograniczają rozmiar i złożoność sieci neuronowych, które mogą być wdrażane, często wymagając znacznego kompresowania i optymalizacji modelu. Inżynierowie muszą równoważyć złożoność modelu, szybkość wnioskowania i wymagania dotyczące dokładności – na przykład, model zoptymalizowany do wykrywania pieszych w czasie rzeczywistym może wymagać poświęcenia zdolności do klasyfikacji subtelnych cech. Ponadto, aktualizowanie modeli AI w wdrożonych czujnikach musi odbywać się w ramach istniejących ograniczeń pamięci i przetwarzania, jednocześnie utrzymując niezawodność.

Rozmiar piksela i wydajność kwantowa stwarzają własne wyzwania projektowe: W miarę jak producenci dążą do wyższej rozdzielczości i zwiększonych możliwości przetwarzania AI, mniejsze rozmiary pikseli mogą kompromitować czułość na światło i zakres dynamiki, podczas gdy większe piksele ograniczają ogólną rozdzielczość sensora. Wydajność kwantowa – jak efektywnie piksele przekształcają światło w sygnały elektryczne – staje się kluczowa w warunkach słabego oświetlenia lub gdy wymagana jest precyzyjna dokładność kolorów. Poprawy w jednym obszarze często odbywają się kosztem innych, takich jak zwiększanie rozmiaru piksela dla lepszej czułości na światło i redukcja przestrzeni dostępnej dla obwodów przetwarzania AI na chipie.

Ograniczenia przetwarzania danych i przechowywania dodają jeszcze więcej złożoności: Te sensory generują ogromne ilości danych, które wymagają efektywnego zarządzania i rozwiązań przechowywania. Wysokoprędkościowe, ciągłe strumienie danych z sensorów wzmocnionych AI mogą przytłaczać tradycyjne łańcuchy przetwarzania danych i czasami wymagają specjalizowanych architektur sprzętowych oraz optymalizowanych systemów zarządzania danymi. Inżynierowie muszą projektować architektury, które mogą obsługiwać te przepływy danych, jednocześnie utrzymując przetwarzanie w czasie rzeczywistym. Może to oznaczać wdrażanie zaawansowanych technik kompresji danych i filtrowania, aby skutecznie zarządzać wymaganiami przepustowości.

Perspektywy na przyszłość

Czujniki obrazu wzmocnione sztuczną inteligencją stanowią znaczący postęp w technologii wizji maszynowej – i dziedzina ta rozwija się w szybkim tempie. W miarę jak producenci rozwijają techniki miniaturyzacji i poprawiają efektywność energetyczną, te czujniki będą stawać się coraz bardziej zaawansowane i dostępne. Chociaż obecne zastosowania obejmują od precyzyjnego rolnictwa po konserwację dzieł sztuki, pełny potencjał technologii pozostaje w dużej mierze nieodkryty, z nowymi przypadkami użycia pojawiającymi się codziennie w różnych branżach.

Profesjonaliści z branży elektronicznej powinni śledzić te rozwój uważnie, aby utrzymać swoją konkurencyjną przewagę. Ci, którzy zrozumieją zarówno techniczne ograniczenia, jak i nadzwyczajne możliwości tych czujników, będą prowadzić następną falę innowacji – tworząc systemy, które zawężają przepaść między ludzkim a maszynowym widzeniem. W miarę dojrzewania tych technologii, obiecują one rozwiązywanie skomplikowanych wyzwań rzeczywistego świata w sposób, który dzisiejsi inżynierowie dopiero zaczynają wyobrażać sobie.