Jak rozwija się wbudowana sztuczna inteligencja w 2020 roku i później

AI, uczenie maszynowe, IoT, edge computing… lista modnych słów w społecznościach zajmujących się sprzętem i oprogramowaniem wbudowanym jest długa, ale te wyróżniają się, ponieważ stały się bardziej powszechne poza kręgiem deweloperów. Postęp w dziedzinie ogólnego zastosowania obliczeń wbudowanych w ciągu ostatnich ~10 lat jest imponujący i doszedł do punktu, w którym mogę wdrożyć jeden z węzłów blockchain mojej firmy w mojej kieszeni. Obliczenia o ogólnym przeznaczeniu zdecydowanie przeszły długą drogę i przekształciły współczesne życie.

A co z wbudowaną AI? Patrząc na postępy w platformach obliczeniowych dla wbudowanej AI, zdecydowanie pozostawała ona w tyle za ogólnym obliczeniem wbudowanym. W ostatnim czasie wbudowana AI nie była naprawdę wbudowana i w dużym stopniu polegała na chmurze. Nowa klasa ASIC ma zmienić dynamikę wbudowanej AI, a projektanci sprzętu powinni przygotować się do budowania systemów wokół tych nowych komponentów. Oto co nadchodzi w świecie wbudowanej AI i jak nowe systemy wbudowane mogą wykorzystać te zmiany.

Od chmury do edge

Marzeniem w dziedzinie wbudowanej AI jest energooszczędne obliczanie na krawędzi z wykorzystaniem specjalistycznego sprzętu. Modele AI na tych urządzeniach muszą być możliwe do trenowania, zarówno na poziomie urządzenia, jak i w chmurze, co następnie wymagałoby przesłania wytrenowanego modelu z powrotem na krawędź. Patrząc na niedawną przeszłość i ewolucję krajobrazu AI, widzieliśmy powolne przenoszenie możliwości obliczeniowych z chmury na krawędź.

Wiele z tego jest wspomagane przez tańsze, bardziej potężne platformy obliczeniowe wbudowane. Coś takiego jak płyta Raspberry Pi czy BeagleBone jest wystarczająco potężne, aby zapewnić numeryczne przewidywanie lub proste klasyfikacje (np. obrazy, tekst lub audio) na poziomie urządzenia z wstępnie wytrenowanymi modelami. Jednak trenowanie na poziomie urządzenia z wykorzystaniem tych platform zajmuje znaczną ilość czasu, więc najlepiej byłoby przeprowadzić je w chmurze. Nowe platformy sprzętowe specyficzne dla AI próbują wypełnić tę lukę i odniosły sukces w przyspieszaniu obliczeń i umożliwieniu bardziej zaawansowanych zadań. Przykładem jest połączone wykrywanie obiektów, rozpoznawanie twarzy i klasyfikacja obrazów z danych wideo, co umożliwia zastosowania w bezpieczeństwie i motoryzacji, między innymi.

Postęp wbudowanej AI od chmury do krawędzi.

Google i NVIDIA znajdowały się ostatnio w swoistym wyścigu zbrojeń, aby wypuścić platformy sprzętowe specjalizujące się w aplikacjach wbudowanej AI. Jednostka przetwarzająca TensorFlow (TPU) od Google została wydana jako część platformy sprzętowej Coral; ta platforma jest specjalizowana do uruchamiania modeli TensorFlow na urządzeniu. To zbliża ją do prawdziwej specjalistycznej platformy wbudowanej AI.

Platforma NVIDIA Jetson nadal przypomina ogólnego przeznaczenia platformę obliczeniową, ponieważ używa GPU, ale firmware jest specjalizowany pod kątem obliczeń AI na urządzeniu. Obecnie dostępne są cztery opcje specjalizowane pod kątem AI od NVIDIA, które mogą być wdrażane w aplikacjach wbudowanych. Produkty NVIDIA nadal zużywają stosunkowo dużo energii i generują ekstremalne ciepło, ponieważ są zbudowane na starszej architekturze GPU, co ogranicza ich użyteczność w mniejszych produktach IoT.

Wąskie gardła wbudowanego AI: Obserwuj specjalizowane układy scalone AI

Wąskim gardłem w wbudowanym AI nie jest ograniczenie przetwarzania, ale ograniczenie rozmiaru i ciepła. Moc przetwarzania ogólnego przeznaczenia istnieje, a produkty GPU/TPU zostały zdegradowane do ogólnego zastosowania wbudowanego AI. Pomyśl o Amazon Alexa; nie potrzebujesz procesora specyficznego dla aplikacji do zadań wbudowanego AI, ponieważ urządzenie musi wykonywać wiele innych funkcji. Ponadto, otrzymuje stałą moc z gniazdka sieciowego i jest zaprojektowane do ciągłego połączenia z internetem. Zakres zadań do wykonania przez tę klasę systemów wbudowanych jest na tyle szeroki, że specjalizowane układy scalone nie są konieczne.

Nowe produkty IoT w wysoko specyficznych aplikacjach i funkcjach potrzebują czegoś nowego: specjalizowanego układu scalonego AI. Kiedy mówię o „specjalizowanym układzie scalonym AI”, nie mam na myśli GPU czy TPU. Zamiast tego, mam na myśli układ scalony z specjalizowaną architekturą sprzętową do uruchamiania konkretnych typów modeli AI z niższym zużyciem energii i niewielką liczbą lub brakiem peryferiów.

Startupy IC bez własnych fabryk krok po kroku wypełniają tę lukę nową własnością intelektualną, która może być wdrażana w innych produktach, lub z samodzielnymi układami scalonymi, które zapewniają wysoko specyficzne możliwości wbudowanego AI. Jedna z firm, z którą współpracuję, ma wkrótce wydać właśnie taki produkt skierowany na 5G-IoT, robotykę, Przemysł 4.0 i inne obszary, gdzie oczekuje się dominacji wbudowanego AI.

Jeśli budujesz nowe produkty IoT, robotykę, produkty motoryzacyjne lub inne systemy, które potrzebują wbudowanych możliwości AI, zwróć uwagę na nowsze specjalizowane układy scalone AI z niektórymi z następujących funkcji:

- Szkolenie na urządzeniu: Ten aspekt wbudowanego AI nadal polega na mocy obliczeniowej chmury, ale najlepsze specjalizowane układy scalone AI umożliwią szkolenie na urządzeniu, np. w aplikacjach uczenia nadzorowanego.

- Szybkie interfejsy: Oczywiście, każdy specjalizowany układ scalony AI musi łączyć się z innymi komponentami na płycie, i będzie używać jakiegoś szybkiego interfejsu. I2C i SPI są idealnymi interfejsami, chociaż spodziewałbym się, że inne szybkie interfejsy będą używane do łączenia z peryferiami komputerowymi.

- Optymalizacja dla konkretnych modeli AI: Modele AI/ML wiążą się z redundantnymi obliczeniami macierzowymi i krokami optymalizacji, a architektura sprzętowa będzie zaprojektowana do wykonania algorytmów zaangażowanych w różne modele AI/ML. Niskie zużycie energii: Osiągnięcie poziomów mocy poniżej mW dla obliczeń AI jest kluczowe dla trwałego szkolenia na urządzeniu, klasyfikacji i prognozowania w aplikacjach AI wymagających dużej ilości danych. Zoptymalizowana architektura może pomóc projektantom przezwyciężyć wąskie gardło ciepła, co również pozwala na zmniejszenie ogólnych rozmiarów nowego produktu.

Pełne koło: Powrót do centrum danych

Spodziewam się, że w ciągu najbliższych kilku lat zostaną szeroko wprowadzone nowe specjalizowane układy scalone i rdzenie IP. Ta zmiana z ogólnego przetwarzania na sprzęt specyficzny dla aplikacji pozwoli na rozwój bardziej zaawansowanych aplikacji wbudowanego AI. Producenci OEM będą mogli produkować mniejsze urządzenia o większej wydajności obliczeniowej niż mogłyby zapewnić ogólnego przeznaczenia MCU.

Mówiłem o wbudowanym AI w kontekście poziomu krawędzi, ale specjalizowane układy scalone AI mogą łatwo przesączyć się z powrotem w górę hierarchii sieci do poziomu centrum danych. Przeniesienie tych zadań z procesorów ogólnego przeznaczenia na ASIC zmniejszy ogólne zużycie energii na poziomie centrum danych.

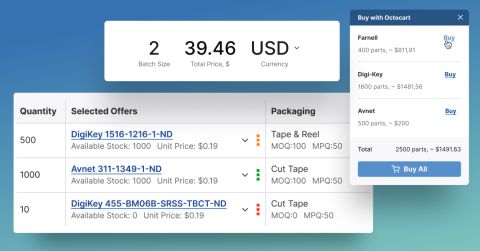

Krajobraz elektroniki może szybko się zmieniać, a wbudowane AI nie jest wyjątkiem. Niezależnie od tego, czy szukasz najnowszych układów scalonych ASIC dla wbudowanego AI, czy jakiegokolwiek innego komponentu do nowego produktu, Octopart będzie tutaj, aby pomóc Ci znaleźć potrzebne komponenty.

Zapoznaj się z naszymi najnowszymi artykułami, zapisując się na nasz newsletter.