Gra Mocą—Skuteczne Projektowanie Systemów Dostarczania Energii

W całej branży elementem projektowym, który nadal sprawia najwięcej problemów, jest system dostarczania energii (PDS). Jako firma konsultingowa, przez ostatnie kilka lat większość problemów, do rozwiązania których zostaliśmy wezwani, zawsze koncentrowała się na problemach z PDS. Jak zauważyłem w moim poprzednim blogu na temat ścieżek ochronnych i ich nieskuteczności, za każdym razem, gdy zostaliśmy poproszeni o rozwiązanie problemu z EMI, zawsze kończyło się to na naprawie PDS.

W tym artykule omówiona zostanie ewolucja wyzwań projektowych PDS, jak one powstały i metody używane do ich łagodzenia. Część druga tego artykułu, adresuje projektowanie PDS dla implementacji o ultra niskim poborze mocy.

Trochę historii i mnóstwo problemów

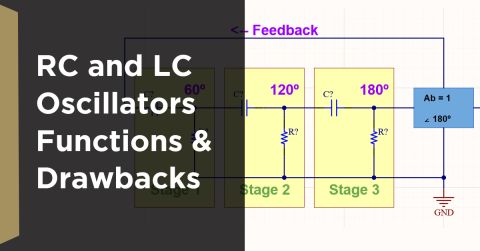

Po pierwsze, kilka podstaw: wszystkie PDSy mają zarówno indukcyjność (wyrażoną jako Lp) jak i oporność (wyrażoną jako Rp) w szereg z miejscem, gdzie płynie moc. Przy niskich prądach, oporność nie stanowi problemu. Przy niskich częstotliwościach, indukcyjność również nie. Jak tylko zaczynasz zwiększać częstotliwość, indukcyjność staje się głównym źródłem degradacji.

Więc cofnijmy się na chwilę, aby zobaczyć, kiedy takie kwestie jak indukcyjność i oporność stały się przedmiotem zainteresowania. Co najważniejsze, możemy zobaczyć, gdzie "czarna magia" projektowania PDS weszła do gry.

Kiedy zaczęliśmy używać płyt dwustronnych, czas narastania sygnałów na nich wynosił czasami dziesiątki nanosekund. Zawartość częstotliwości była naprawdę niska i, w rezultacie, ścieżki na płytach nie stanowiły problemu. Cała moc była rozprowadzana za pomocą ścieżek, a nie płaszczyzn. Można było umieścić kondensator na ścieżce zasilającej każdy układ scalony, między +5 a masą każdego układu scalonego, i to wystarczało. Następnie na scenę wkroczyła technologia ECL (emitter coupled logic).

Technologia ECL nigdy nie mogłaby działać bez płaszczyzn na płytach, ponieważ czasy narastania były poniżej nanosekundy. To właśnie w tym miejscu użycie ścieżek do dystrybucji mocy stało się nieakceptowalne. Z powodu szybkich czasów narastania, po prostu nie można było podłączyć zasilania za pomocą ścieżek. Indukcyjność była zbyt duża. Więc od samego początku technologii ECL zawsze istniała para płaszczyzn mocy. Inżynierowie używający technologii ECL w swoich projektach rozumieli to i używali płaszczyzn mocy.

Teraz przejdźmy do TTL (logiki tranzystor-tranzystor). W przypadku podstawowego TTL można było prowadzić zasilanie za pomocą ścieżek. Następnie pojawił się ASTTL (zaawansowany Schottky TTL). Był równie szybki jak ECL, ale inżynierowie projektujący produkty z jego użyciem próbowali stosować te same metody, co przy wolnym TTL, i obwody nie były stabilne. Efektem były przerażające zakłócenia elektromagnetyczne (EMI). Ludzie próbowali używać kondensatorów o pojemności .1 i .01 mikrofarada, ale to nie działało. I wtedy zaczęły pojawiać się wszystkie te zasady czarnej magii.

W domenie publicznej praktycznie nie było inżynierów EMI, a ponieważ inżynierowie używający TTL nie rozumieli takich rzeczy jak linie transmisyjne, dostarczanie energii i prowadzenie szybkich sygnałów, wpadali w poważne kłopoty. Produkt mógł nie przejść testu EMI, a inżynier projektant pytał osobę przeprowadzającą test, co należy z tym zrobić, a inżynier testujący (który nie rozumiał projektowania PDS) cytował coś, co ktoś inny zrobił, aby poprawić sytuację, i to było zapisywane na liście i przekazywane dalej. Te listy były genezą zasad "czarnej magii".

Rola kondensatorów w projektowaniu PDS i poza nim

Jednym z wyników stosowania zasad "czarnej magii" było to, że gdy nadszedł czas na projektowanie PDS, ludzie mieli tendencję do umieszczania na swoich płytach dużej ilości kondensatorów w próbie naprawienia problemów z PDS, nie rozumiejąc naprawdę, jak te kondensatory działały lub nie działały. Stąd wzięła się koncepcja kondensatorów sprzęgających. W rzeczywistości te kondensatory nie rozprzęgają niczego. Zamiast tego dostarczają lokalne źródło ładunku, aby wspierać zdarzenie przełączania.

Są one lepiej określane jako "wiadra kulombów", ponieważ magazynują kulomby ładunku używane do wspierania zdarzeń przełączania. (Kulomb to jednostka ładunku elektrycznego w Międzynarodowym Układzie Jednostek. Jest to ładunek przenoszony przez stały prąd jednego ampera w ciągu jednej sekundy). Jeśli użyte kondensatory nie mają odpowiedniego rozmiaru lub nie funkcjonują na zaangażowanych częstotliwościach, wynikiem jest ripple na Vdd. (Vdd to terminal zasilania, który łączy się z końcem drenu tranzystora MOS lub CMOS lub układu scalonego. Jest to zazwyczaj najbardziej dodatnia szyna zasilania). Szczegółowe omówienie tego tematu pojawiło się w artykule Lee Ritcheya na Altium Resource, "Win at Power Delivery System Design", opublikowanym 17 stycznia 2019).

W 1995 roku wydział EMC Uniwersytetu Missouri, Rolla (obecnie Uniwersytet Nauki i Technologii Missouri) zademonstrował, jak klasyczne użycie kondensatorów do omijania PDS nie było skuteczne w rozwiązywaniu problemów z EMI (patrz Referencja 2). (Wysoka impedancja oznacza duże tętnienia i potencjalne EMI.) Rysunek 1 pokazuje trzy krzywe impedancji vs. częstotliwość wynikające z tego badania.

Rysunek 1. Impedancja PDS vs Częstotliwość z pracy UMR

Rysunek 1. Impedancja PDS vs Częstotliwość z pracy UMR

Wykres dzięki uprzejmości IEEE i Todda Hubinga

W istocie, kondensatory o pojemności .1 i .01 mikrofarada poprawiły wydajność systemu zasilania (zmniejszyły jego impedancję) do około 70MHZ. Od 70MHZ wzwyż, pogarszają one impedancję, a następnie w końcu przestają działać. Konkretnie, to pasożytnicza indukcyjność szeregowa z kondensatorami sprawia, że stają się one bezużyteczne po przekroczeniu pewnej częstotliwości. To, co pokazało to badanie, to że jedynym sposobem na kontrolę impedancji przy wysokich częstotliwościach (powyżej 100MHZ) jest użycie pojemności płaszczyznowej. Ilość potrzebnej pojemności można określić, ustalając liczbę linii transmisyjnych, które muszą być napędzane jednocześnie. W przypadku przełączania linii transmisyjnych, ładunek jest przenoszony z zasilacza do linii transmisyjnej. Na tej podstawie można określić, jak duży musi być urządzenie do przechowywania ładunku (lub wiadro kulombowe).

Więc, aby zapewnić stabilną pracę i brak EMI, konieczny jest naprawdę solidny PDS. W tym przypadku, solidny oznacza dostarczanie prądu na bardzo wysokich częstotliwościach (powyżej 100MHZ), co można osiągnąć tylko dzięki pojemności płaszczyzny. Oczywistym sposobem na stworzenie pojemności płaszczyzny na PCB jest dodanie dwóch warstw płaszczyzn dla tego celu. Te warstwy płaszczyzn mogą być wykonane z materiału specjalnego, takiego jak ZBC od Sanmina lub innych materiałów opracowanych w tym celu. Alternatywnie, gdy PCB posiada kilka płaszczyzn, mogą być one rozmieszczone w taki sposób, że pary płaszczyzn znajdują się naprzeciwko siebie na kawałku laminatu lub prepregu. Każda z metod osiąga pożądane rezultaty. Zaletą umieszczania warstw płaszczyzn obok siebie, w porównaniu z użyciem specjalnego materiału takiego jak ZBC, jest to, że nie dodaje to premii do kosztu PCB wynikającej z użycia specjalnego materiału.

Ale co zrobić, gdy mamy do czynienia z małymi płytami, takimi jak czterowarstwowe płyty w Xboxie, gdzie nie ma wystarczająco dużo miejsca na płycie, aby zapewnić pojemność płaszczyzn? Jedynym rozwiązaniem jest przeniesienie wysokiej jakości pojemności bezpośrednio na obudowę układu scalonego i na sam krzem. Od dziesięcioleci firmy takie jak AMD i Intel wbudowują pojemność w swoje części, ponieważ większość ich produktów była montowana na płytach czterowarstwowych. Jednakże, aż do siedmiu lub ośmiu lat temu, dostawcy FPGA nie wbudowywali pojemności w swoje części. Doprowadziło to do licznych przypadków, gdy budowane płyty okazywały się niesprawne. W niektórych przypadkach firmy musiały całkowicie przeprojektować swoje produkty, co skutkowało przegapionymi oknami produktowymi i wysokimi kosztami NRE. W innych przypadkach, te firmy, które nie mogły sobie pozwolić na ponowne projektowanie lub przegapiły okna rynkowe, po prostu upadały. Na szczęście teraz wszyscy główni dostawcy FPGA „zrozumieli” i wbudowali pojemność w swoje części.

Następnym dużym wyzwaniem były wszystkie układy scalone, które mają miliard tranzystorów i wymagają 100 amper przy 0,9 wolta. Dlatego wyzwaniem było dostarczenie bardzo wysokich prądów przy bardzo niskich napięciach, gdzie nie ma dużego pola manewru dla spadku napięcia. Oznacza to, że potrzeba rozwiązania problemu oporu znów wysunęła się na pierwszy plan. Udało się to osiągnąć, redukując liczbę warstw sygnałowych w stosie i zastępując je dodatkowymi płaszczyznami masy. Na przykład, w 22-warstwowej płytce zbudowanej dla produktu do monitorowania sieci wysokiej prędkości, środkowe cztery warstwy stały się jednouncjowymi płaszczyznami Vdd i masy ułożonymi równolegle.

Ale teraz, nawet zmiana stosu warstw nie wystarcza. Poza patrzeniem na napięcie końcowe na wyjściu zasilacza, pojawia się potrzeba kompensacji spadku napięcia, który występuje po tym. Dla tych bardzo wysokich prądów, są dwie linie pomiarowe, które są częścią pętli sprzężenia zwrotnego. Jedna linia idzie do terminala masy, a druga do terminala Vdd. Te linie pomiarowe nie są podłączone na wyjściu zasilacza. Zamiast tego, są one prowadzone przez kilka dedykowanych pinów na

Vdd i masa wewnątrz obudowy układu scalonego, tak aby napięcie było odczuwane na krzemie, a nie na płytce. Osoba projektująca układ scalony musi zapewnić pojedynczy pin, który jest izolowany od płaszczyzn Vdd i masy w obudowie. Jeden z dostawców określa je mianem "dziurek szpiegowskich", ponieważ pozwalają one wejść i zmierzyć, co dzieje się na die.

Dzisiaj nie jest rzadkością posiadanie dwóch lub trzech miliardów tranzystorów na chipie. Celem obecnie nie jest już upychanie większej liczby tranzystorów na chipie, ale sprawienie, aby były szybsze. Jest to technologia FinFET, gdzie MOSFET jest budowany na podłożu, na którym bramka jest umieszczona z dwóch, trzech lub czterech stron kanału lub jest owinięta wokół kanału, tworząc podwójną strukturę bramki. W tej architekturze masz bardzo wąskie bramki o szerokości 14nm, a kanał wznosi się z dwóch stron. Tak producenci chipów osiągają te bardzo małe wymiary. Jest to również powód, dla którego napięcie musi spaść, ponieważ grubości tlenków są takie, że nie mogą tolerować bardzo wysokich napięć i dochodzi do przebicia między źródłem a drenem. To technologia, która napędza 56Gbps—wiele tranzystorów w bardzo małych wymiarach z bardzo cienkimi warstwami tlenku. Chodzi wszystko o wydajność i szybsze przełączanie.

Podsumowanie

W trakcie historii projektowania PDS przeszliśmy od niezwracania uwagi ani na opór, ani na indukcyjność, do konieczności zwracania uwagi najpierw na opór, a później na indukcyjność, a teraz znowu musimy zwracać uwagę na opór. Podejście pin-on-chip adresuje problem oporu, a producenci chipów dostarczają takie rozwiązania od ostatnich siedmiu lub ośmiu lat. Wiedzą, że muszą zajmować się problemami PDS wewnątrz opakowania. Jednak, jak w większości aspektów naszej technologii, dobrym pomysłem jest poproszenie dostawców układów scalonych o dostarczenie płytki demonstracyjnej, która pokazuje, jak układ scalony działa w sposób, który jest potrzebny, zanim zobowiążesz się do umieszczenia go na swojej płytce.

Referencje

1. Ritchey, Lee W. i Zasio, John J., „Right The First Time, A Practical Handbook on High-Speed PCB and System Design, Volumes 1 and 2.” 2. Hubing, Todd, etal, „PWB Power Structures: Theory and Design,” University of Missouri, Rolla, listopad 1999.

Chcesz dowiedzieć się więcej o tym, jak Altium może pomóc Ci w następnym projekcie PCB? Porozmawiaj z ekspertem w Altium.