Komponenten hinter den heutigen bahnbrechenden Smart- und AR-Brillen

Brillen entwickeln sich zum neuesten persönlichen Geräteformat, das Mode, Funktion und Konnektivität in einem eleganten Paket vereint. Laut IDC wird erwartet, dass die Lieferungen von intelligenten und Augmented Reality (AR)-Brillen im Jahr 2025 um 39 % wachsen, 14 Millionen Einheiten erreichen und bis 2029 auf 43 Millionen ansteigen.

Der Markt wird derzeit von intelligenten Brillen (auch bekannt als KI-Brillen) angetrieben, mit einem Wachstum von 250 % im Jahr 2025, doch die nächste Generation von AR-Brillen steht bereits vor der Tür. Von Metas kamera- und KI-fähigen Ray-Bans bis hin zu XREALs leichten AR-Displaybrillen bewegt sich die Kategorie in den täglichen Gebrauch von Millionen.

Wichtige Erkenntnisse

- Intelligente und AR-Brillen beschleunigen die Annahme im Mainstream, mit globalen Umsatzprognosen, die bis 2030 25–30 Milliarden Dollar übertreffen.

- Fortschritte bei Displays, Sensoren und Stromsystemen treiben Innovationen bei kamera- und KI-basierter intelligenter Augenbekleidung voran und die Entwicklung zu leichten AR-Designs mit echten visuellen Überlagerungen.

- Durchbrüche von Lieferanten wie Sony, Qualcomm, Bosch und Renesas machen Brillen leichter, komfortabler und leistungsfähiger und verwandeln Augenbekleidung in die nächste Grenze der persönlichen Technik.

Die Technologie im Rahmen

Das Wachstum wird durch eine Kaskade von Komponentendurchbrüchen angetrieben. Miniaturkameras und MEMS-Mikrofone, Mikro-OLED-Displays, präzise IMUs und energiedichte Batterien wurden alle so entwickelt, dass sie in einen Rahmen passen, der nicht mehr wiegt als ein Paar alltäglicher, stilvoller Brillen.

Jedes neue Produkt stellt einen ausgeklügelten Balanceakt aus Optik, Thermik, Konnektivität und Stil dar. Das Ergebnis ist eine Brille, die vertraut aussieht, aber die Art von Rechenleistung bietet, die einst leistungsstarken Smartphones vorbehalten war. Die heutigen Smart- und AR-Brillen zeigen, wie weit die Komponenteninnovation gekommen ist, und es ist leicht vorstellbar, wie viel weiter sie noch gehen kann und wird.

Smart Glasses werden zum Mainstream

Die aktuelle Generation von Smart Glasses bevorzugt Kommunikation, KI-Assistenz und bequeme Bedienung ohne Hände gegenüber erweiterten visuellen Darstellungen. Anstatt Grafiken zu projizieren, erfassen sie Bilder und Videos, streamen Audio und verbinden sich in Echtzeit mit KI-Assistenten. In diesen schlanken Rahmen befindet sich eine beeindruckende Sammlung von Teilen.

Die Ray-Ban Meta-Brillen laufen beispielsweise auf dem Qualcomm Snapdragon AR1 Gen 1 Chipsatz, einem speziell optimierten Silizium für kompakte Kameraverarbeitung und Verbindungen mit geringer Latenz. Darüber hinaus nutzen diese marktführenden Smart Glasses eine Reihe beeindruckender Komponenten:

- SoC + ISP: die dualen Bildsignalprozessoren des AR1 verarbeiten 12 MP Fotos und 6 MP Videos direkt auf dem Gerät, was Hitze und Verzögerungen minimiert.

- Audio-Subsystem: offene Ohr-Mikrolautsprecher und beam-forming Knowles MEMS Mikrofone – wie das SPH1644LM4H1 – ermöglichen klare, freihändige Anrufe.

- Bewegungssensorik: ein Bosch BMI270 IMU verfolgt Kopfbewegungen für Stabilisierung und Gestensteuerung.

- Batterie und Kraftstoffanzeige: eine einzelne Li-Ion-Batterie in Kombination mit TI’s bq27441 liefert eine genaue Laufzeitprognose.

Die Designer haben auch Schlüsselprobleme hinsichtlich Komfort gelöst: Gewichtsverteilung, passive Kühlung und transparente akustische Kanäle. Diese Fortschritte haben intelligente Brillen leicht, modisch, funktional und praktisch zum Tragen in der Öffentlichkeit gemacht.

Das Sichtfeld zum Leben erwecken: Displays und Optik

Während Kamera- und KI-basierte Smart-Brillen heute den Mainstream erreichen, ist die nächste Grenze die visuelle Augmentation – AR-Brillen, die ein echtes digitales Bild in Ihr Sichtfeld projizieren. Unter den Verbrauchergeräten sind die XREAL One Pro AR-Brillen zu einem Referenzdesign für das derzeit Mögliche geworden. Sie verwenden zwei Sony 0,55-Zoll-Mikro-OLED-Panels, die mit 1080p/120 Hz laufen und einen 57-Grad-Sichtfeld mit lebendigem Kontrast und einer Helligkeit von bis zu 700 Nits erreichen. Der flache Prismenoptik-Motor des Unternehmens faltet das Licht effizient, sodass es in einem schlanken Rahmen Platz findet.

Mikro-OLED-Displays bleiben das Arbeitspferd moderner AR-Brillen. Sie liefern reiche Farben, exzellenten Kontrast und eine handhabbare thermische Leistung, was allesamt kritisch für ein Gerät ist, das nur Millimeter von den Augen des Benutzers entfernt sitzt. Ihr Nachteil ist die Helligkeit; bei voller Intensität kämpfen sie immer noch gegen direktes Sonnenlicht.

Um diese Grenze zu überwinden und eine Outdoor-Funktionalität zu erreichen, wenden sich Entwickler der Wellenleiteroptik zu. Dies sind die klaren, lichtleitenden Schichten, die projizierte Bilder in die Sicht des Trägers biegen. Zwei Hauptansätze dominieren:

- Reflektive Wellenleiter (Lumus, SCHOTT) nutzen winzige Spiegel, um Licht mit hoher Effizienz umzuleiten, was sie hell genug für den Außeneinsatz macht.

- Diffraktive Wellenleiter (Dispelix, DigiLens) verwenden nanostrukturierte Gitter, um rotes, grünes und blaues Licht in einem einzigen dünnen Blatt zu kombinieren. Das Ergebnis sind stromlinienförmige, leichte Rahmen.

Beide haben Vor- und Nachteile. Reflektive Typen bieten Helligkeit und geringes „Augenleuchten“, fügen aber einige Millimeter Dicke hinzu; diffraktive Typen sind dünner, können aber Farbuniformität und Effizienz verlieren. In der Zwischenzeit versprechen Mikro-LED-Mikrodisplays – wie das JBD’s MicroLED AMμLED™ 0.13 Series MIPI Mikrodisplay – sonnenlichtlesbare AR, sobald die Produktion im Jahr 2026 hochgefahren wird. Dieses Mikrodisplay liefert außergewöhnliche 6.350 Pixel pro Zoll (PPI) und positioniert sich damit unter den weltweit kleinsten und hellsten Mikrodisplays.

Rechnen und Sensing: Das Gehirn und die Augen

Da sich die Displays verbessern, muss das Rechenrückgrat Schritt halten. Viele High-End-AR-Systeme verlassen sich mittlerweile auf Qualcomms XR2 Gen 2 und XR2+ Gen 2 Chipsets, die darauf ausgelegt sind, bis zu zehn gleichzeitige Kameras und Echtzeit-Raumkartierung zu bewältigen.

Um diese Prozessoren herum entsteht eine wachsende Konstellation von Sensoren:

- IMUs wie der ST ISM330IS übernehmen Bewegungstracking und Stabilisierung.

- Sensoren wie Sonys IMX560 SPAD ToF, kombiniert mit ams-OSRAM VCSEL Beleuchtung für Tiefenerkennung, werden zur Kartierung der Umgebung eingesetzt.

- Kameras und Bildsensormodule wie das 5 MP OmniVision OV716 CIS kümmern sich um die Erfassung der Außenwelt, Augenverfolgung und Gestenerkennung.

Ein einziges Paar AR-Brillen kann jetzt mehr als acht Sensoren integrieren, die alle einen synchronisierten Datenstrom liefern, der innerhalb von Millisekunden fusioniert werden muss. Latenz, nicht rohe Verarbeitungsgeschwindigkeit, bestimmt, wie natürlich sich die Erfahrung anfühlt. Diese Herausforderung hat SoC-Anbieter dazu veranlasst, dedizierte Sensorhubs und AI-Kerne zu integrieren, wodurch die Grenze zwischen Berechnung und Wahrnehmung/Sensorik verschwimmt.

Leistung, Thermik und Konnektivität

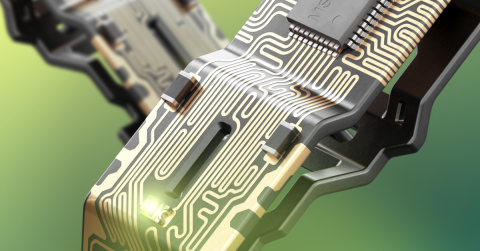

Unabhängig davon, wie leistungsfähig die Optik oder Prozessoren sind, bestimmt das Energiemanagement immer noch, wie lange diese Geräte laufen können und wie komfortabel sie sich anfühlen. Die meisten Designs verwenden eine einzelne Li-Ionen-Zelle, die zwischen den beiden Bügelarmen aufgeteilt ist, verbunden durch ein flexibles PCB-Band.

Um die Wärme von den Bügeln wegzuleiten, verlassen sich Ingenieure auf Panasonic PGS Graphitfolien und GraphiteTIM-Pads (wie EYGS182307), die die Wärme seitlich durch das Gestell leiten, anstatt sie in der Nähe des Bügels aufzubauen. Der Unterschied zwischen 38°C und 43°C bei Hautkontakt ist der Unterschied zwischen tragbar und untragbar.

Konnektivitätsmodule fügen ihre eigene Komplexität hinzu. Murata Type 2FY und 2EA-Module kombinieren Wi-Fi 6/7 und Bluetooth LE in kompakten, abgeschirmten Paketen. Begleitende Controller, wie die Renesas DA1470x BLE SoCs, verwalten Benutzereingaben, Sprachaktivierung und Energiezustände, ohne den Hauptprozessor zu wecken. Selbst die Platzierung der Antenne ist ein sorgfältiger Balanceakt, der Raum mit Lautsprechern, Mikrofonen und Kameraöffnungen in nur wenigen Millimetern Kunststoff teilt.

Die nächste Welle des alltäglichen AR

Die Grenze zwischen Smart Glasses und AR-Brillen beginnt zu verschwimmen. SCHOTTs geometrische reflektierende Wellenleiter haben 2025 die Produktion hochgefahren, und die jüngste Veröffentlichung von Metas neuen displayfähigen Ray-Bans signalisieren beide, dass Verbraucher-AR fast bereit für die Hauptsendezeit ist. Die ersten Modelle werden sich auf flüchtig sichtbare Daten konzentrieren – einschließlich Untertiteln, Navigation und Benachrichtigungen – anstatt auf vollständige Videos oder 3D-Überlagerungen, um die Energiebudgets realistisch zu halten.

Da sich die optische Effizienz verbessert und die Batteriechemie weiterentwickelt, werden Brillen längere Tragezeiten und bessere Lesbarkeit im Freien bieten, ohne das Design zu opfern. Bemerkenswert ist, wie inkrementell diese Durchbrüche sind: dünnere Graphitverteiler, hellere Mikrodisplays und etwas intelligentere PMICs.

Für Hardware-Designer bedeutet diese Konvergenz mehr interdisziplinäre Arbeit: Optikingenieure arbeiten zusammen mit PCB-Layout-Teams, Firmware-Entwickler stimmen Energieprofile für Komfort ab, Beschaffungsmanager verfolgen Wellenleiterlieferanten, wie sie einst GPUs verfolgten.

Notizen aus dem Feld: Die Zukunft tragen

Nach monatelanger regelmäßiger Nutzung sind diese Geräte Teil meiner täglichen Routine geworden. Ich trage meine Meta Ray-Ban AI-Brille an den meisten Tagen, während ich durch die Stadt laufe und über offene Ohrhörer ein Hörbuch oder Musik höre. Keine Ohrstöpsel, die in meinen Ohren stecken oder für andere sichtbar sind, keine Abkopplung von der Welt um mich herum. Wenn eine WhatsApp-Benachrichtigung eingeht, flüstert die Brille die Nachricht in mein Ohr, freihändig, während ich mich auf die Straße vor mir oder den Ladenbesitzer, mit dem ich plaudere, konzentriere. Wenn ich eine Frage habe, frage ich leise, als ob ich mit mir selbst oder einem AI-Freund in meinem Kopf spreche, und ich bekomme sofort eine Antwort. Es fühlt sich an wie die Zukunft.

Die Brille sieht aus wie stilvolle Alltagsrahmen, sodass die Leute nicht bemerken, dass ich mit Technik interagiere, und es fühlt sich an, als würde ich unter dem Radar operieren.

Bei langen Flügen wechsle ich zu meinen XREAL One Pro AR-Brillen. Angeschlossen an mein Telefon oder Laptop über USB-C, zeigen sie mir eine großflächige Micro-OLED-Ansicht direkt vor mir – so fühle ich mich statt in einer beengten Flugzeugkabine wie in einem geräumigen, privaten Großkino. Dies, zusammen mit geräuschunterdrückenden Kopfhörern, macht einen langen Flug in der Economy-Klasse viel erträglicher.

Diese persönlichen Erfahrungen unterstreichen die zentrale technologische Errungenschaft hier: Die Hardware ist endlich klein, kühl und effizient genug geworden, um in alltägliche Rahmen zu verschwinden und das, was einst sperrige Headsets erforderte, in etwas so Einfaches wie das Aufsetzen von Brillen zu verwandeln.

Ein neuer Formfaktor, der unvermeidlich erscheint

Smart- und AR-Brillen markieren die nächste Phase des persönlichen Computings: ambient, freihändig und nahtlos in das tägliche Leben integriert. Statt ein Gerät herauszuziehen, um mit Informationen zu interagieren, leben wir neben ihr: Fragen laut stellend, Antworten in unserem Ohr empfangend, die Welt in Echtzeit erweitert sehend. Da die Komponenten kleiner, intelligenter und effizienter werden, beweisen Brillen, dass die mächtigste Technologie jene ist, die präsent ist, wenn sie benötigt wird, und unsichtbar, wenn nicht.

Ob Sie zuverlässige Leistungselektronik oder fortschrittliche digitale Systeme für die nächste Welle intelligenter und AR-Geräte entwickeln, Altium Develop bringt jede Disziplin in einer kollaborativen Umgebung zusammen, frei von Silos und Grenzen. Erleben Sie Altium Develop noch heute, um zu sehen, wie eine einheitliche Plattform Ingenieuren, Designern und Innovatoren hilft, ohne Einschränkungen gemeinsam zu erschaffen.