Cómo la IA integrada está evolucionando en 2020 y más allá

IA, aprendizaje automático, IoT, computación en el borde... la lista de palabras de moda en las comunidades de hardware y software embebido es larga, pero estas destacan ya que se han vuelto más comunes más allá de los desarrolladores. El progreso en la computación embebida de propósito general durante los últimos ~10 años es impresionante y ha llegado al punto donde puedo desplegar uno de los nodos blockchain de mi empresa en mi bolsillo trasero. La computación de propósito general ciertamente ha recorrido un largo camino y ha transformado la vida moderna.

¿Qué pasa con la IA embebida? Si miras los avances en plataformas de computación para IA embebida, ciertamente ha quedado atrás en comparación con la computación embebida de propósito general. En el pasado reciente, la IA embebida no era realmente embebida y dependía en gran medida de la nube. Una nueva clase de ASICs está preparada para cambiar la dinámica de la IA embebida, y los diseñadores de hardware deberían prepararse para construir sistemas alrededor de estos nuevos componentes. Esto es lo que viene en el mundo de la IA embebida y cómo los nuevos sistemas embebidos pueden aprovechar estos cambios.

De la Nube al Borde

El sueño en la IA embebida es la computación eficiente en energía en el borde con hardware especializado. Los modelos de IA en estos dispositivos necesitan ser entrenables, ya sea a nivel del dispositivo o en la nube, lo que luego requeriría transmitir el modelo entrenado de vuelta al borde. Mirando el pasado reciente y cómo ha evolucionado el panorama de la IA, hemos visto una lenta transferencia de capacidades de computación de la nube al borde.

Gran parte de esto es ayudado por plataformas de computación embebida más baratas y poderosas. Algo como una placa Raspberry Pi o BeagleBone es lo suficientemente potente para proporcionar predicción numérica o clasificación simple (por ejemplo, imágenes, texto o audio) a nivel del dispositivo con modelos preentrenados. Sin embargo, el entrenamiento a nivel del dispositivo con estas plataformas lleva una cantidad significativa de tiempo, por lo tanto, el entrenamiento se realizaría mejor en la nube. Las nuevas plataformas de hardware específicas para IA están tratando de llenar el vacío y han tenido éxito en acelerar la computación y habilitar tareas más avanzadas. Un ejemplo es la detección de objetos combinada, reconocimiento facial y clasificación de imágenes a partir de datos de video, lo que permite aplicaciones en seguridad y automoción, entre otros.

Progreso de la IA embebida de la nube al borde.

Google y NVIDIA han estado en una especie de carrera armamentista recientemente para lanzar plataformas de hardware que están especializadas para aplicaciones de IA embebida. La unidad de procesamiento TensorFlow (TPU) de Google se lanzó como parte de la plataforma de hardware Coral; esta plataforma está especializada para ejecutar modelos TensorFlow en el dispositivo. Esto la acerca más a una verdadera plataforma de IA embebida específica para aplicaciones.

La plataforma Jetson de NVIDIA todavía se asemeja a una plataforma de computación de propósito general en el sentido de que utiliza GPUs, pero el firmware está especializado para cálculos de IA en el dispositivo. Actualmente, hay cuatro opciones especializadas en IA disponibles de NVIDIA que pueden implementarse en aplicaciones embebidas. Estos productos de NVIDIA todavía consumen una cantidad de energía relativamente grande y generan un calor extremo ya que están construidos sobre una arquitectura GPU heredada, lo que limita su utilidad en productos IoT más pequeños.

Cuellos de botella en IA embebida: Atención a los ICs especializados en IA

El cuello de botella en la IA embebida no es un cuello de botella de procesamiento, es un cuello de botella de tamaño y calor. La potencia de procesamiento de propósito general existe, y los productos GPU/TPU han sido relegados a IA embebida de propósito general. Piense en Amazon Alexa; no necesita un procesador específico de aplicación para tareas de IA embebida ya que hay muchas otras funciones que el dispositivo necesita realizar. Además, recibe energía constante del enchufe de la pared y está diseñado para estar constantemente conectado a internet. La gama de tareas a realizar por esta clase de sistemas embebidos es lo suficientemente amplia como para que no sean necesarios ICs especializados.

Los nuevos productos IoT en aplicaciones y funciones altamente específicas necesitan algo nuevo: un IC especializado en IA. Cuando me refiero a un “IC especializado en IA”, no me estoy refiriendo a un GPU o TPU. En cambio, me refiero a un IC con una arquitectura de hardware especializada para ejecutar tipos específicos de modelos de IA con un consumo de energía más bajo y pocos o ningún periférico.

Las startups de IC sin fábrica están dando un paso adelante para llenar el vacío con nueva propiedad intelectual que puede implementarse en otros productos, o con ICs independientes que proporcionan capacidades de IA embebida altamente específicas de aplicación. Una empresa con la que estoy trabajando está a punto de lanzar justo un producto para apuntar a 5G-IoT, robótica, Industria 4.0 y otras áreas donde se espera que domine la IA embebida.

Si estás construyendo nuevos productos IoT, robótica, productos automotrices u otros sistemas que necesitan capacidades de IA embebida, estate atento a los nuevos ICs especializados en IA con algunas de las siguientes características:

- Entrenamiento en el dispositivo: Este aspecto de la IA embebida todavía depende de la potencia de computación en la nube, pero los mejores ICs especializados en IA permitirán el entrenamiento en el dispositivo, por ejemplo, en aplicaciones de aprendizaje supervisado.

- Interfaces de alta velocidad: Obviamente, cualquier IC especializado en IA necesita interfaz con otros componentes en una placa, y utilizará alguna interfaz de alta velocidad. I2C y SPI son interfaces ideales, aunque esperaría que se usen otras interfaces de alta velocidad para conectarse con periféricos de computadora.

- Optimización para modelos específicos de IA: Los modelos de IA/ML involucran cálculos de matrices redundantes y pasos de optimización, y la arquitectura de hardware estará diseñada para ejecutar los algoritmos involucrados en diferentes modelos de IA/ML. Consumo de energía bajo: Llegar a niveles de energía sub-mW para cálculos de IA es crítico para el entrenamiento persistente en el dispositivo, clasificación y predicción en aplicaciones de IA con grandes volúmenes de datos. Una arquitectura optimizada puede ayudar a los diseñadores a superar el cuello de botella del calor, lo que también permite reducir el tamaño general de un nuevo producto.

Full Circle: Trayéndolo de vuelta al Centro de Datos

Esperaría que nuevos ICs especializados y núcleos de IP sean lanzados ampliamente en los próximos años. Este cambio de la computación de propósito general a hardware específico de aplicación es lo que permitirá aplicaciones de IA embebida más avanzadas. Los OEM podrán producir dispositivos más pequeños con una mayor eficiencia computacional de la que podrían proporcionar los MCUs de propósito general.

He estado hablando sobre la IA embebida en términos del nivel de borde, pero los ICs especializados en IA pueden fácilmente filtrarse de nuevo hacia arriba en la jerarquía de la red hasta el nivel del centro de datos. Descargar estas tareas de los procesadores de propósito general a un ASIC reducirá el consumo total de energía en el nivel del centro de datos.

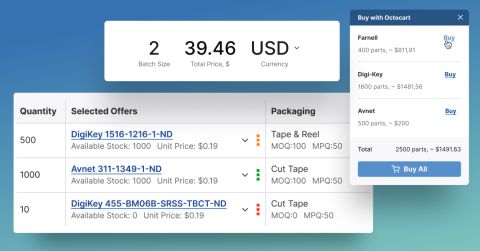

El panorama electrónico puede cambiar rápidamente, y la IA embebida no es una excepción. Ya sea que estés buscando los ASICs de IA embebida más nuevos o cualquier otro componente para un nuevo producto, Octopart estará aquí para ayudarte a encontrar los componentes que necesitas.

Mantente al día con nuestros últimos artículos suscribiéndote a nuestro boletín.