Come l'AI integrata sta evolvendo nel 2020 e oltre

AI, apprendimento automatico, IoT, edge computing... la lista di parole d'ordine nelle comunità di hardware e software incorporato è lunga, ma queste spiccano poiché sono diventate più comuni al di là degli sviluppatori. Il progresso nel computing incorporato a scopo generale negli ultimi ~10 anni è impressionante e ha raggiunto il punto in cui posso distribuire uno dei nodi blockchain della mia azienda nella mia tasca posteriore. Il computing a scopo generale ha certamente fatto molta strada e ha trasformato la vita moderna.

Che dire dell'AI incorporata? Se si guardano i progressi nelle piattaforme di computing per l'AI incorporata, questa è certamente rimasta indietro rispetto al computing incorporato a scopo generale. Nel recente passato, l'AI incorporata non era veramente incorporata e si affidava pesantemente al cloud. Una nuova classe di ASIC è pronta a cambiare la dinamica dell'AI incorporata, e i progettisti hardware dovrebbero prepararsi a costruire sistemi intorno a questi nuovi componenti. Ecco cosa sta arrivando nel mondo dell'AI incorporata e come i nuovi sistemi incorporati possono trarre vantaggio da questi cambiamenti.

Dal Cloud al Edge

Il sogno nell'AI incorporata è il calcolo efficiente dal punto di vista energetico al edge con hardware specializzato. I modelli di AI su questi dispositivi devono essere addestrabili, sia a livello di dispositivo che nel cloud, il che richiederebbe poi la trasmissione del modello addestrato al edge. Guardando al recente passato e a come è evoluto il panorama dell'AI, abbiamo assistito a un lento trasferimento delle capacità di calcolo dal cloud al edge.

Molto di ciò è aiutato da piattaforme di computing incorporato più economiche e potenti. Qualcosa come una scheda Raspberry Pi o BeagleBone è abbastanza potente da fornire previsioni numeriche o classificazioni semplici (ad esempio, immagini, testo o audio) a livello di dispositivo con modelli pre-addestrati. Tuttavia, l'addestramento a livello di dispositivo con queste piattaforme richiede una quantità significativa di tempo, quindi l'addestramento sarebbe meglio eseguito nel cloud. Nuove piattaforme hardware specifiche per l'AI stanno cercando di colmare il divario e sono state efficaci nell'accelerare il calcolo e abilitare compiti più avanzati. Un esempio è la combinazione di rilevamento di oggetti, riconoscimento facciale e classificazione di immagini da dati video, che abilita applicazioni nella sicurezza e nell'automotive, tra gli altri.

Progresso dell'AI incorporata dal cloud al edge.

Google e NVIDIA sono stati in una sorta di gara agli armamenti di recente per rilasciare piattaforme hardware specializzate per applicazioni di AI incorporata. L'unità di elaborazione TensorFlow (TPU) di Google è stata rilasciata come parte della piattaforma hardware Coral; questa piattaforma è specializzata per eseguire modelli TensorFlow sul dispositivo. Questo la avvicina a una vera piattaforma di AI incorporata specifica per applicazione.

La piattaforma Jetson di NVIDIA assomiglia ancora a una piattaforma di calcolo generale in quanto utilizza GPU, ma il firmware è specializzato per calcoli AI sul dispositivo. Attualmente, ci sono quattro opzioni specializzate in AI disponibili da NVIDIA che possono essere impiegate in applicazioni embedded. Questi prodotti NVIDIA consumano ancora una quantità di energia relativamente elevata e generano un calore estremo poiché sono costruiti su un'architettura GPU legacy, il che limita la loro utilità in prodotti IoT più piccoli.

Colli di bottiglia nell'AI Embedded: Attenzione agli IC specializzati in AI

Il collo di bottiglia nell'AI embedded non è un problema di elaborazione, ma di dimensione e calore. La potenza di elaborazione generale esiste, e i prodotti GPU/TPU sono stati relegati all'AI embedded generale. Pensate ad Amazon Alexa; non è necessario un processore specifico per le applicazioni per compiti di AI embedded poiché ci sono molte altre funzioni che il dispositivo deve eseguire. Inoltre, riceve energia costante dalla presa di corrente ed è progettato per essere costantemente connesso a Internet. La gamma di compiti da eseguire da questa classe di sistemi embedded è abbastanza ampia da non rendere necessari IC specializzati.

I nuovi prodotti IoT in applicazioni e funzioni altamente specifiche necessitano di qualcosa di nuovo: un IC specializzato in AI. Quando mi riferisco a un "IC specializzato in AI", non sto parlando di una GPU o TPU. Invece, mi riferisco a un IC con un'architettura hardware specializzata per eseguire tipi specifici di modelli AI con un consumo di energia inferiore e pochi o nessun periferico.

Le startup IC fabless stanno facendo passi avanti per colmare il divario con nuove IP che possono essere implementate in altri prodotti, o con IC autonomi che forniscono capacità di AI embedded altamente specifiche per l'applicazione. Un'azienda con cui sto lavorando sta per rilasciare proprio un tale prodotto per targettizzare 5G-IoT, robotica, Industria 4.0 e altre aree dove si prevede che l'AI embedded dominerà.

Se stai costruendo nuovi prodotti IoT, robotica, prodotti automobilistici o altri sistemi che necessitano di capacità AI embedded, fai attenzione ai nuovi IC specializzati in AI con alcune delle seguenti caratteristiche:

- Addestramento on-device: Questo aspetto dell'AI embedded si affida ancora alla potenza di calcolo cloud, ma i migliori IC specializzati in AI permetteranno l'addestramento on-device, ad esempio, in applicazioni di apprendimento supervisionato.

- Interfacce ad alta velocità: Ovviamente, qualsiasi IC specializzato in AI deve interfacciarsi con altri componenti su una scheda, e utilizzerà qualche interfaccia ad alta velocità. I2C e SPI sono interfacce ideali, anche se mi aspetterei che altre interfacce ad alta velocità vengano utilizzate per connettersi con periferiche informatiche.

- Ottimizzazione per modelli AI specifici: I modelli AI/ML comportano calcoli di matrici ridondanti e passaggi di ottimizzazione, e l'architettura hardware sarà progettata per eseguire gli algoritmi coinvolti in diversi modelli AI/ML. Consumo di energia ridotto: Raggiungere livelli di potenza sub-mW per i calcoli AI è critico per l'addestramento persistente on-device, la classificazione e la previsione in applicazioni AI ricche di dati. Un'architettura ottimizzata può aiutare i progettisti a superare il collo di bottiglia del calore, consentendo anche di ridurre le dimensioni complessive di un nuovo prodotto.

Il Cerchio si Chiude: Ritorno al Data Center

Mi aspetto che nei prossimi anni vengano rilasciati nuovi IC specializzati e core IP su larga scala. Questo passaggio dalla computazione generica all'hardware specifico per applicazione è ciò che permetterà applicazioni AI embedded più avanzate. Gli OEM saranno in grado di produrre dispositivi più piccoli con una maggiore efficienza computazionale rispetto a quella che potrebbe essere fornita da MCU generici.

Ho parlato di AI embedded in termini di livello edge, ma gli IC specializzati in AI possono facilmente risalire la gerarchia di rete fino al livello del data center. Scaricare questi compiti dai processori generici su un ASIC ridurrà il consumo energetico complessivo a livello di data center.

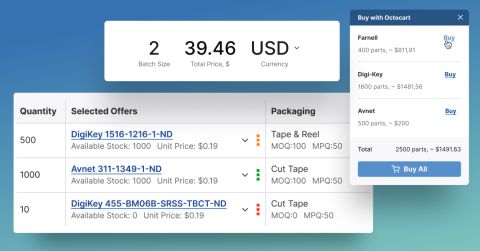

Il panorama dell'elettronica può cambiare rapidamente, e l'AI embedded non fa eccezione. Che tu stia cercando i più recenti ASIC per AI embedded o qualsiasi altro componente per un nuovo prodotto, Octopart sarà qui per aiutarti a trovare i componenti di cui hai bisogno.

Rimani aggiornato con i nostri ultimi articoli iscrivendoti alla nostra newsletter.