Sự Phát Triển của AI Nhúng vào Năm 2020 và Hơn Thế Nữa

AI, học máy, IoT, tính toán biên... danh sách các từ khóa trong cộng đồng phần cứng và phần mềm nhúng là dài, nhưng những từ này nổi bật vì chúng đã trở nên phổ biến hơn ngoài giới phát triển. Sự tiến bộ trong tính toán nhúng mục đích chung trong khoảng ~10 năm qua thật ấn tượng và đã đạt đến điểm mà tôi có thể triển khai một trong những nút blockchain của công ty mình trong túi sau của mình. Tính toán mục đích chung chắc chắn đã đi một chặng đường dài và đã biến đổi cuộc sống hiện đại.

Vậy còn AI nhúng thì sao? Nếu bạn nhìn vào những tiến bộ trong các nền tảng tính toán dành cho AI nhúng, nó chắc chắn đã tụt hậu so với tính toán nhúng mục đích chung. Trong quá khứ gần đây, AI nhúng không thực sự được nhúng và phụ thuộc nhiều vào đám mây. Một lớp mới của ASICs đang đặt ra để thay đổi động lực của AI nhúng, và các nhà thiết kế phần cứng nên chuẩn bị bản thân để xây dựng hệ thống xung quanh những thành phần mới này. Dưới đây là những gì sắp xảy ra trong thế giới của AI nhúng và cách các hệ thống nhúng mới có thể tận dụng những thay đổi này.

Từ Đám Mây đến Biên

Giấc mơ trong AI nhúng là tính toán hiệu quả về năng lượng tại biên với phần cứng chuyên biệt. Các mô hình AI trên những thiết bị này cần được huấn luyện, hoặc tại cấp độ thiết bị hoặc trong đám mây, điều này sau đó sẽ yêu cầu truyền mô hình đã được huấn luyện trở lại biên. Nhìn lại quá khứ gần đây và cách mà bối cảnh AI đã phát triển, chúng ta đã thấy một sự chuyển dịch chậm rãi của khả năng tính toán từ đám mây sang biên.

Nhiều điều này được hỗ trợ bởi các nền tảng tính toán nhúng rẻ hơn, mạnh mẽ hơn. Một cái gì đó như Raspberry Pi hoặc bảng BeagleBone đủ mạnh để cung cấp dự đoán số hoặc phân loại đơn giản (ví dụ, hình ảnh, văn bản, hoặc âm thanh) tại cấp độ thiết bị với các mô hình đã được huấn luyện trước. Tuy nhiên, việc huấn luyện tại cấp độ thiết bị với những nền tảng này mất một lượng thời gian đáng kể, do đó việc huấn luyện sẽ tốt nhất được thực hiện trong đám mây. Các nền tảng phần cứng chuyên biệt cho AI mới hơn đang cố gắng lấp đầy khoảng trống và đã thành công trong việc tăng tốc độ tính toán và cho phép thực hiện nhiều nhiệm vụ tiên tiến hơn. Một ví dụ là kết hợp phát hiện đối tượng, nhận dạng khuôn mặt, và phân loại hình ảnh từ dữ liệu video, điều này cho phép ứng dụng trong an ninh và ô tô, cùng nhiều lĩnh vực khác.

Tiến bộ của AI nhúng từ đám mây đến biên.

Google và NVIDIA gần đây đã có một cuộc đua vũ trang để phát hành các nền tảng phần cứng chuyên biệt cho các ứng dụng AI nhúng. Đơn vị xử lý TensorFlow (TPU) của Google đã được phát hành như một phần của nền tảng phần cứng Coral; nền tảng này chuyên biệt cho việc chạy các mô hình TensorFlow trên thiết bị. Điều này đưa nó gần hơn với một nền tảng AI nhúng chuyên biệt thực sự.

Nền tảng Jetson của NVIDIA vẫn giống như một nền tảng tính toán đa năng vì nó sử dụng GPU, nhưng firmware được chuyên biệt hóa cho các tính toán AI trên thiết bị. Hiện tại, có bốn lựa chọn chuyên biệt về AI có sẵn từ NVIDIA có thể được triển khai trong các ứng dụng nhúng. Những sản phẩm của NVIDIA này vẫn tiêu thụ một lượng điện năng tương đối lớn và tạo ra nhiệt độ cực cao vì chúng được xây dựng trên kiến trúc GPU cũ, điều này hạn chế tính hữu ích của chúng trong các sản phẩm IoT nhỏ hơn.

Những Rào Cản của AI Nhúng: Chú Ý đến IC Chuyên Biệt cho AI

Rào cản trong AI nhúng không phải là rào cản về xử lý, mà là rào cản về kích thước và nhiệt độ. Sức mạnh xử lý đa năng tồn tại, và các sản phẩm GPU/TPU đã được chuyển sang sử dụng cho AI nhúng đa năng. Hãy nghĩ về Amazon Alexa; bạn không cần một bộ xử lý chuyên dụng cho các nhiệm vụ AI nhúng vì có nhiều chức năng khác mà thiết bị cần thực hiện. Hơn nữa, nó nhận điện liên tục từ ổ cắm tường và được thiết kế để luôn kết nối với internet. Phạm vi các nhiệm vụ được thực hiện bởi lớp hệ thống nhúng này rộng lớn đến mức không cần thiết phải có IC chuyên biệt.

Các sản phẩm IoT mới trong các ứng dụng và chức năng cụ thể cao cần một thứ mới: một IC chuyên biệt cho AI. Khi tôi đề cập đến "IC chuyên biệt cho AI", tôi không đề cập đến GPU hay TPU. Thay vào đó, tôi đề cập đến một IC với kiến trúc phần cứng chuyên biệt để chạy các loại mô hình AI cụ thể với mức tiêu thụ điện năng thấp và ít hoặc không có phụ kiện.

Các startup IC không có nhà máy đang nỗ lực lấp đầy khoảng trống với IP mới có thể được triển khai trong các sản phẩm khác, hoặc với các IC độc lập cung cấp khả năng AI nhúng chuyên biệt cho ứng dụng cao. Một công ty mà tôi đang làm việc với dự định phát hành một sản phẩm như vậy để nhắm đến 5G-IoT, robot, Công nghiệp 4.0, và các lĩnh vực khác nơi AI nhúng được kỳ vọng sẽ thống trị.

Nếu bạn đang xây dựng các sản phẩm IoT mới, robot, sản phẩm ô tô, hoặc các hệ thống khác cần khả năng AI nhúng, hãy chú ý đến các IC chuyên biệt cho AI mới với một số tính năng sau:

- Đào tạo trên thiết bị: Khía cạnh này của AI nhúng vẫn phụ thuộc vào sức mạnh tính toán đám mây, nhưng các IC chuyên biệt cho AI tốt nhất sẽ cho phép đào tạo trên thiết bị, ví dụ, trong các ứng dụng học có giám sát.

- Giao diện tốc độ cao: Rõ ràng, bất kỳ IC chuyên biệt cho AI nào cũng cần giao diện với các thành phần khác trên bảng mạch, và nó sẽ sử dụng một số giao diện tốc độ cao. I2C và SPI là các giao diện lý tưởng, mặc dù tôi mong đợi các giao diện tốc độ cao khác được sử dụng để kết nối với các phụ kiện máy tính.

- Tối ưu hóa cho các mô hình AI cụ thể: Các mô hình AI/ML liên quan đến các tính toán ma trận lặp lại và các bước tối ưu hóa, và kiến trúc phần cứng sẽ được thiết kế để thực hiện các thuật toán liên quan đến các mô hình AI/ML khác nhau. Mức tiêu thụ điện năng thấp: Giảm xuống mức tiêu thụ điện năng dưới mW cho các tính toán AI là rất quan trọng cho việc đào tạo, phân loại, và dự đoán trên thiết bị liên tục trong các ứng dụng AI nặng về dữ liệu. Một kiến trúc tối ưu hóa có thể giúp các nhà thiết kế vượt qua rào cản nhiệt độ, điều này cũng cho phép giảm kích thước tổng thể của một sản phẩm mới.

Vòng Tròn Đầy Đủ: Quay Trở Lại Trung Tâm Dữ Liệu

Tôi mong đợi các IC chuyên biệt mới và lõi IP sẽ được phát hành rộng rãi trong vài năm tới. Sự chuyển dịch này từ tính toán đa năng sang phần cứng chuyên dụng cho ứng dụng cụ thể là điều sẽ cho phép các ứng dụng AI nhúng tiên tiến hơn. Các nhà sản xuất thiết bị gốc (OEMs) sẽ có thể sản xuất các thiết bị nhỏ gọn hơn với hiệu quả tính toán cao hơn so với những gì có thể được cung cấp bởi các MCU đa năng.

Tôi đã nói về AI nhúng ở cấp độ edge, nhưng các IC chuyên biệt cho AI có thể dễ dàng lọc trở lại cấp độ trung tâm dữ liệu qua hệ thống mạng. Việc chuyển các nhiệm vụ này từ các bộ xử lý đa năng sang một ASIC sẽ giảm tổng mức tiêu thụ năng lượng ở cấp độ trung tâm dữ liệu.

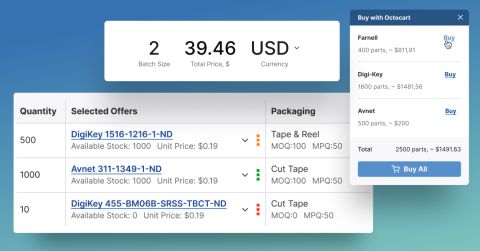

Bức tranh điện tử có thể thay đổi nhanh chóng, và AI nhúng không phải là ngoại lệ. Cho dù bạn đang tìm kiếm các ASIC AI nhúng mới nhất hay bất kỳ linh kiện nào khác cho một sản phẩm mới, Octopart sẽ ở đây để giúp bạn tìm kiếm các linh kiện bạn cần.

Hãy cập nhật với các bài viết mới nhất của chúng tôi bằng cách đăng ký nhận bản tin của chúng tôi.