2020년과 그 이후에 임베디드 AI가 어떻게 발전하고 있는가

AI, 머신러닝, IoT, 엣지 컴퓨팅... 임베디드 하드웨어 및 소프트웨어 커뮤니티에서의 유행어 목록은 길지만, 개발자를 넘어서 더 일반적으로 사용되면서 이들이 돋보입니다. 지난 약 10년 동안 일반 목적의 임베디드 컴퓨팅의 발전은 인상적이며, 제 회사의 블록체인 노드를 제 뒷주머니에 배치할 수 있는 지점에 도달했습니다. 일반 목적 컴퓨팅은 확실히 크게 발전했으며 현대 생활을 변화시켰습니다.

임베디드 AI는 어떨까요? 임베디드 AI를 위한 컴퓨팅 플랫폼의 발전을 살펴보면, 일반 목적의 임베디드 컴퓨팅에 비해 확실히 뒤처져 있습니다. 최근까지 임베디드 AI는 실제로 임베디드되지 않았으며 클라우드에 크게 의존했습니다. 새로운 클래스의 ASICs가 임베디드 AI의 역학을 변화시킬 준비가 되어 있으며, 하드웨어 디자이너들은 이 새로운 구성 요소를 중심으로 시스템을 구축할 준비를 해야 합니다. 임베디드 AI의 세계에서 다가오는 것과 이러한 변화를 활용할 수 있는 새로운 임베디드 시스템에 대해 알아보겠습니다.

클라우드에서 엣지로

임베디드 AI의 꿈은 전문 하드웨어에서 엣지에서의 전력 효율적인 계산입니다. 이러한 장치에서의 AI 모델은 장치 수준이나 클라우드에서 학습 가능해야 하며, 그 후에 학습된 모델을 엣지로 다시 전송해야 합니다. 최근 과거를 돌아보고 AI 환경이 어떻게 발전했는지 살펴보면, 클라우드에서 엣지로의 컴퓨팅 능력 이전이 느리게 진행되었습니다.

이는 더 저렴하고 강력한 임베디드 컴퓨팅 플랫폼에 의해 도움을 받았습니다. Raspberry Pi나 BeagleBone 보드와 같은 것은 사전 학습된 모델을 사용하여 장치 수준에서 수치 예측이나 간단한 분류(예: 이미지, 텍스트 또는 오디오)를 제공하기에 충분히 강력합니다. 그러나 이러한 플랫폼에서 장치 수준에서의 학습은 상당한 시간이 걸리므로, 학습은 클라우드에서 수행하는 것이 가장 좋습니다. 새로운 AI 전용 하드웨어 플랫폼은 이 격차를 메우려고 시도하고 있으며 계산 속도를 높이고 더 고급 작업을 가능하게 하는 데 성공했습니다. 예를 들어, 보안 및 자동차 등의 분야에서 활용될 수 있는 비디오 데이터로부터의 결합된 객체 감지, 얼굴 인식 및 이미지 분류가 있습니다.

클라우드에서 엣지로의 임베디드 AI 진보.

Google과 NVIDIA는 최근 임베디드 AI 애플리케이션에 특화된 하드웨어 플랫폼을 출시하기 위한 일종의 경쟁을 벌이고 있습니다. Google의 TensorFlow 처리 장치(TPU)는 장치에서 TensorFlow 모델을 실행하기 위해 특화된 Coral 하드웨어 플랫폼의 일부로 출시되었습니다. 이는 진정한 애플리케이션 특화 임베디드 AI 플랫폼에 더 가깝습니다.

NVIDIA의 Jetson 플랫폼은 여전히 GPU를 사용하는 일반 컴퓨팅 플랫폼과 유사하지만, 펌웨어는 장치에서의 AI 계산에 특화되어 있습니다. 현재 임베디드 애플리케이션에 배포할 수 있는 NVIDIA의 네 가지 AI 전문 옵션이 있습니다. 이 NVIDIA 제품들은 여전히 상대적으로 많은 전력을 소비하고 극심한 열을 발생시키는데, 이는 레거시 GPU 아키텍처를 기반으로 하기 때문이며, 이는 작은 IoT 제품에서의 유용성을 제한합니다.

임베디드 AI 병목 현상: AI 전문 IC에 주목하세요

임베디드 AI의 병목 현상은 처리량 문제가 아니라 크기와 열 문제입니다. 일반적인 처리 능력은 존재하며, GPU/TPU 제품은 일반적인 임베디드 AI에 할당되었습니다. Amazon Alexa를 생각해 보세요; 임베디드 AI 작업에 애플리케이션별 프로세서가 필요하지 않습니다. 왜냐하면 장치가 수행해야 할 다른 많은 기능들이 있기 때문입니다. 또한, 이는 벽면 콘센트에서 지속적인 전력을 받고 인터넷에 지속적으로 연결되도록 설계되었습니다. 이러한 임베디드 시스템 클래스가 수행해야 할 작업 범위는 충분히 넓어 특수 IC가 필요하지 않습니다.

고도로 특정된 애플리케이션과 기능을 가진 새로운 IoT 제품은 새로운 것이 필요합니다: AI 전문 IC. "AI 전문 IC"라고 할 때, GPU나 TPU를 말하는 것이 아닙니다. 대신, 특정 유형의 AI 모델을 실행하기 위한 전문 하드웨어 아키텍처를 가진 IC를 말하며, 이는 낮은 전력 소비와 거의 또는 전혀 주변 장치가 없습니다.

팹리스 IC 스타트업들이 다른 제품에 구현할 수 있는 새로운 IP로, 또는 고도로 애플리케이션별 임베디드 AI 기능을 제공하는 독립형 IC로 이 공백을 메우기 위해 나서고 있습니다. 저와 협력하는 한 회사는 바로 이러한 제품을 5G-IoT, 로보틱스, 산업 4.0 및 임베디드 AI가 지배할 것으로 예상되는 기타 분야를 대상으로 출시할 예정입니다.

새로운 IoT 제품, 로보틱스, 자동차 제품 또는 임베디드 AI 기능이 필요한 기타 시스템을 구축하고 있다면, 다음과 같은 기능을 갖춘 새로운 AI 전문 IC에 주목하세요:

- 장치 내 훈련: 이 임베디드 AI의 측면은 여전히 클라우드 컴퓨팅 파워에 의존하지만, 최고의 AI 전문 IC는 예를 들어, 감독 학습 애플리케이션에서 장치 내 훈련을 허용할 것입니다.

- 고속 인터페이스: 당연히, 모든 AI 전문 IC는 보드의 다른 구성 요소와 인터페이스해야 하며, 고속 인터페이스를 사용할 것입니다. I2C와 SPI는 이상적인 인터페이스이지만, 컴퓨터 주변 장치와 연결하기 위해 다른 고속 인터페이스가 사용될 것으로 예상합니다.

- 특정 AI 모델 최적화: AI/ML 모델은 중복 행렬 계산과 최적화 단계를 포함하며, 하드웨어 아키텍처는 다양한 AI/ML 모델에 관련된 알고리즘을 실행하도록 설계될 것입니다. 낮은 전력 소비: AI 계산을 위한 서브 mW 전력 수준으로 내려가는 것은 데이터가 많은 AI 애플리케이션에서 지속적인 장치 내 훈련, 분류 및 예측에 중요합니다. 최적화된 아키텍처는 설계자가 열 병목 현상을 극복하는 데 도움을 줄 수 있으며, 이는 새로운 제품의 전체 크기를 줄일 수 있도록 합니다.

전체 과정: 데이터 센터로 돌아가기

향후 몇 년 안에 새로운 전문화된 IC와 IP 코어가 널리 출시될 것으로 예상합니다. 일반 목적의 컴퓨팅에서 애플리케이션 특화 하드웨어로의 이 전환은 보다 고급 임베디드 AI 애플리케이션을 가능하게 할 것입니다. OEM은 일반 목적의 MCU가 제공할 수 있는 것보다 더 작은 장치를 더 큰 계산 효율성으로 생산할 수 있게 될 것입니다.

저는 에지 레벨에서 임베디드 AI에 대해 이야기해 왔지만, AI 전문 IC는 네트워크 계층 구조를 따라 데이터 센터 레벨로 쉽게 되돌아갈 수 있습니다. 이러한 작업을 일반 목적의 프로세서에서 ASIC으로 오프로딩하면 데이터 센터 레벨에서 전체 전력 소비를 줄일 수 있습니다.

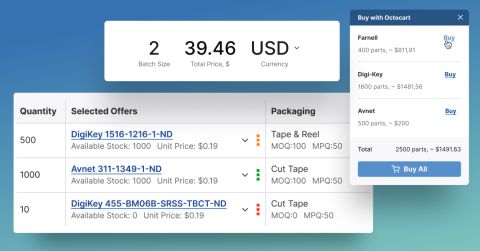

전자 제품의 풍경은 빠르게 변할 수 있으며, 임베디드 AI도 예외는 아닙니다. 새로운 임베디드 AI ASIC을 찾고 있든, 새로운 제품을 위한 다른 구성 요소든, Octopart가 필요한 구성 요소를 찾는 데 도움을 줄 것입니다.

최신 기사를 계속 업데이트하려면 뉴스레터에 가입하세요.