Как встраиваемый ИИ развивается в 2020 году и далее

ИИ, машинное обучение, IoT, вычисления на периферии... список модных слов в сообществах, занимающихся встроенным аппаратным и программным обеспечением, длинный, но эти термины выделяются, так как они стали более распространенными за пределами разработчиков. Прогресс в области универсальных встроенных вычислений за последние ~10 лет впечатляет и достиг той точки, когда я могу развернуть один из узлов блокчейна моей компании у себя в кармане. Универсальные вычисления действительно прошли долгий путь и преобразили современную жизнь.

Что насчет встроенного ИИ? Если посмотреть на достижения в вычислительных платформах для встроенного ИИ, то они определенно отстают от универсальных встроенных вычислений. В последнее время встроенный ИИ на самом деле не был встроенным и в значительной степени зависел от облака. Новый класс ASIC предназначен для изменения динамики встроенного ИИ, и разработчики аппаратного обеспечения должны подготовиться к созданию систем на основе этих новых компонентов. Вот что предстоит в мире встроенного ИИ и как новые встроенные системы могут воспользоваться этими изменениями.

От облака к периферии

Мечта в области встроенного ИИ - это энергоэффективные вычисления на периферии с использованием специализированного аппаратного обеспечения. Модели ИИ на этих устройствах должны быть обучаемыми, либо на уровне устройства, либо в облаке, что затем потребует передачи обученной модели обратно на периферию. Оглядываясь на недавнее прошлое и эволюцию ландшафта ИИ, мы видели медленное смещение вычислительных возможностей от облака к периферии.

Во многом это способствовало более дешевым и мощным платформам встроенных вычислений. Что-то вроде Raspberry Pi или платы BeagleBone достаточно мощно, чтобы обеспечить численное предсказание или простую классификацию (например, изображений, текста или аудио) на уровне устройства с предварительно обученными моделями. Однако обучение на уровне устройства с этими платформами занимает значительное количество времени, поэтому обучение лучше всего проводить в облаке. Новые аппаратные платформы, специфичные для ИИ, пытаются заполнить этот пробел и успешно ускоряют вычисления и позволяют выполнять более сложные задачи. Примером может служить объединенное обнаружение объектов, распознавание лиц и классификация изображений из видеоданных, что позволяет применять их в области безопасности и автомобилестроения, среди прочего.

Прогресс встроенного ИИ от облака к периферии.

Google и NVIDIA недавно оказались в некотором роде гонке вооружений, чтобы выпустить аппаратные платформы, специализированные для приложений встроенного ИИ. Выпущенный в рамках аппаратной платформы Coral процессор обработки TensorFlow (TPU) от Google; эта платформа специализирована для запуска моделей TensorFlow на устройстве. Это приближает его к истинной специализированной платформе встроенного ИИ.

Платформа NVIDIA Jetson по-прежнему напоминает универсальную вычислительную платформу тем, что использует GPU, но прошивка специализирована для вычислений ИИ на устройстве. В настоящее время существует четыре специализированных под ИИ варианта доступных от NVIDIA, которые могут быть использованы во встроенных приложениях. Эти продукты NVIDIA все еще потребляют относительно большое количество энергии и генерируют экстремальное тепло, поскольку они построены на устаревшей архитектуре GPU, что ограничивает их полезность в меньших продуктах IoT.

Узкие места встроенного ИИ: Обратите внимание на специализированные ИС для ИИ

Узкое место встроенного ИИ не в обработке данных, а в размере и тепле. Универсальная вычислительная мощность существует, и продукты GPU/TPU были отнесены к универсальному встроенному ИИ. Подумайте об Amazon Alexa; для задач встроенного ИИ не нужен процессор, специфичный для приложения, поскольку устройству необходимо выполнять множество других функций. Более того, оно получает постоянное питание от сети и предназначено для постоянного подключения к интернету. Спектр задач, выполняемых этим классом встроенных систем, настолько широк, что специализированные ИС не нужны.

Новые продукты IoT в высокоспециализированных приложениях и функциях требуют чего-то нового: специализированной ИС для ИИ. Когда я говорю о «специализированной ИС для ИИ», я не имею в виду GPU или TPU. Вместо этого я имею в виду ИС со специализированной аппаратной архитектурой для выполнения конкретных типов моделей ИИ с низким энергопотреблением и минимальным количеством периферийных устройств.

Компании без собственного производства ИС активно работают над заполнением этого пробела с новым IP, который может быть реализован в других продуктах, или с автономными ИС, которые предоставляют высокоспециализированные возможности встроенного ИИ для конкретных приложений. Одна из компаний, с которой я работаю, готовится выпустить именно такой продукт для целей 5G-IoT, робототехники, Индустрии 4.0 и других областей, где ожидается доминирование встроенного ИИ.

Если вы разрабатываете новые продукты IoT, робототехнику, автомобильные продукты или другие системы, требующие возможностей встроенного ИИ, обратите внимание на новые специализированные ИС для ИИ со следующими функциями:

- Обучение на устройстве: Этот аспект встроенного ИИ все еще зависит от вычислительной мощности облака, но лучшие специализированные ИС для ИИ позволят обучение на устройстве, например, в приложениях с контролируемым обучением.

- Высокоскоростные интерфейсы: Очевидно, что любая специализированная ИС для ИИ должна взаимодействовать с другими компонентами на плате, и она будет использовать какой-либо высокоскоростной интерфейс. I2C и SPI являются идеальными интерфейсами, хотя я ожидаю, что будут использоваться и другие высокоскоростные интерфейсы для подключения к компьютерным периферийным устройствам.

- Оптимизация для конкретных моделей ИИ: Модели ИИ/ML включают в себя повторяющиеся матричные вычисления и шаги оптимизации, и архитектура аппаратного обеспечения будет разработана для выполнения алгоритмов, задействованных в различных моделях ИИ/ML. Низкое энергопотребление: Снижение энергопотребления до уровня менее мВт для вычислений ИИ критично для постоянного обучения на устройстве, классификации и прогнозирования в данных, насыщенных приложениях ИИ. Оптимизированная архитектура может помочь разработчикам преодолеть проблему с теплом, что также позволяет уменьшить общий размер нового продукта.

Замыкая круг: Возвращение к центру обработки данных

Я ожидаю, что в ближайшие пару лет будут широко выпущены новые специализированные ИС и IP-ядра. Этот переход от универсальных вычислений к аппаратному обеспечению, специализированному под конкретные приложения, позволит реализовать более продвинутые встроенные AI приложения. Производители оригинального оборудования смогут производить более маленькие устройства с большей вычислительной эффективностью, чем могли бы предложить универсальные МКУ.

Я говорил о встроенном AI с точки зрения уровня края сети, но специализированные ИС для AI легко могут вернуться вверх по иерархии сети к уровню центра обработки данных. Перенос этих задач с универсальных процессоров на ASIC снизит общее потребление энергии на уровне центра обработки данных.

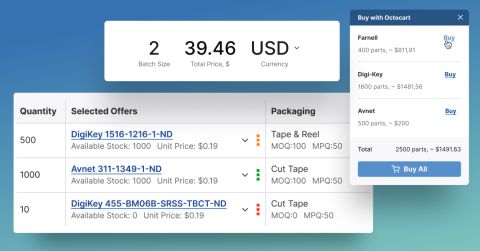

Ландшафт электроники может быстро меняться, и встроенный AI - не исключение. Будь то поиск новейших встроенных AI ASIC или любого другого компонента для нового продукта, Octopart будет здесь, чтобы помочь вам найти необходимые компоненты.

Оставайтесь в курсе наших последних статей, подписавшись на нашу рассылку.