Wie sich eingebettete KI im Jahr 2020 und darüber hinaus entwickelt

KI, maschinelles Lernen, IoT, Edge-Computing… die Liste der Schlagwörter in den Gemeinschaften für eingebettete Hardware und Software ist lang, aber diese stechen hervor, da sie über Entwickler hinaus immer gebräuchlicher geworden sind. Der Fortschritt in der allgemeinen eingebetteten Datenverarbeitung der letzten ~10 Jahre ist beeindruckend und hat den Punkt erreicht, an dem ich einen der Blockchain-Knoten meines Unternehmens in meiner Hosentasche einsetzen kann. Die allgemeine Datenverarbeitung hat sicherlich einen langen Weg zurückgelegt und das moderne Leben verwandelt.

Was ist mit eingebetteter KI? Wenn man sich die Fortschritte bei den Computing-Plattformen für eingebettete KI ansieht, hinkte sie sicherlich der allgemeinen eingebetteten Datenverarbeitung hinterher. In der jüngsten Vergangenheit war eingebettete KI nicht wirklich eingebettet und verließ sich stark auf die Cloud. Eine neue Klasse von ASICs steht bereit, um die Dynamik der eingebetteten KI zu ändern, und Hardware-Designer sollten sich darauf vorbereiten, Systeme um diese neuen Komponenten herum zu bauen. Hier ist, was in der Welt der eingebetteten KI aufkommt und wie neue eingebettete Systeme diese Änderungen nutzen können.

Von der Cloud zum Edge

Der Traum in der eingebetteten KI ist energieeffiziente Berechnung am Edge mit spezialisierter Hardware. Die KI-Modelle auf diesen Geräten müssen trainierbar sein, entweder auf Geräteebene oder in der Cloud, was dann das Übertragen des trainierten Modells zurück zum Edge erfordern würde. Wenn man die jüngste Vergangenheit und die Entwicklung der KI-Landschaft betrachtet, haben wir eine langsame Verlagerung der Rechenkapazitäten von der Cloud zum Edge gesehen.

Vieles davon wird durch günstigere, leistungsfähigere eingebettete Computing-Plattformen unterstützt. Etwas wie ein Raspberry Pi oder BeagleBone Board ist leistungsfähig genug, um numerische Vorhersagen oder einfache Klassifizierungen (z.B. Bilder, Text oder Audio) auf Geräteebene mit vortrainierten Modellen zu liefern. Das Training auf Geräteebene mit diesen Plattformen dauert jedoch erheblich lange, daher wäre das Training am besten in der Cloud durchzuführen. Neuere, speziell für KI entwickelte Hardware-Plattformen versuchen, diese Lücke zu schließen und waren erfolgreich darin, die Berechnung zu beschleunigen und fortgeschrittenere Aufgaben zu ermöglichen. Ein Beispiel ist die kombinierte Objekterkennung, Gesichtserkennung und Bildklassifizierung aus Videodaten, die Anwendungen in Sicherheit und Automobilindustrie unter anderem ermöglicht.

Fortschritt der eingebetteten KI von der Cloud zum Edge.

Google und NVIDIA liefern sich seit kurzem etwas wie ein Wettrüsten, um Hardware-Plattformen zu veröffentlichen, die spezialisiert auf eingebettete KI-Anwendungen sind. Googles TensorFlow-Verarbeitungseinheit (TPU) wurde als Teil der Coral-Hardware-Plattform veröffentlicht; diese Plattform ist spezialisiert auf das Ausführen von TensorFlow-Modellen auf dem Gerät. Dies bringt es näher an eine echte anwendungsspezifische eingebettete KI-Plattform.

NVIDIAs Jetson-Plattform ähnelt immer noch einer allgemeinen Computing-Plattform, da sie GPUs verwendet, aber die Firmware ist spezialisiert auf KI-Berechnungen auf dem Gerät. Derzeit gibt es vier auf KI spezialisierte Optionen von NVIDIA, die in eingebetteten Anwendungen eingesetzt werden können. Diese NVIDIA-Produkte verbrauchen immer noch relativ viel Strom und erzeugen extreme Hitze, da sie auf einer älteren GPU-Architektur basieren, was ihre Nützlichkeit in kleineren IoT-Produkten einschränkt.

Engpässe bei eingebetteter KI: Achten Sie auf KI-spezialisierte ICs

Der Engpass bei eingebetteter KI ist kein Verarbeitungsengpass, es ist ein Größen- und Hitzeengpass. Die allgemeine Verarbeitungsleistung existiert, und GPU/TPU-Produkte wurden zu allgemeinen eingebetteten KI-Anwendungen herabgestuft. Denken Sie an Amazon Alexa; für eingebettete KI-Aufgaben benötigen Sie keinen anwendungsspezifischen Prozessor, da das Gerät viele andere Funktionen ausführen muss. Darüber hinaus erhält es ständig Strom aus der Steckdose und ist darauf ausgelegt, ständig mit dem Internet verbunden zu sein. Das Spektrum der Aufgaben, die von dieser Klasse eingebetteter Systeme ausgeführt werden sollen, ist breit genug, dass spezialisierte ICs nicht notwendig sind.

Neuere IoT-Produkte in hochspezifischen Anwendungen und Funktionen benötigen etwas Neues: einen KI-spezialisierten IC. Wenn ich von einem „KI-spezialisierten IC“ spreche, beziehe ich mich nicht auf eine GPU oder TPU. Stattdessen beziehe ich mich auf einen IC mit spezialisierter Hardwarearchitektur zum Ausführen spezifischer Arten von KI-Modellen mit geringerem Stromverbrauch und wenigen bis keinen Peripheriegeräten.

Fabless-IC-Startups treten an, um die Lücke mit neuem IP zu füllen, das in anderen Produkten implementiert werden kann, oder mit eigenständigen ICs, die hochspezifische eingebettete KI-Fähigkeiten bieten. Ein Unternehmen, mit dem ich zusammenarbeite, steht kurz davor, ein solches Produkt für 5G-IoT, Robotik, Industrie 4.0 und andere Bereiche auf den Markt zu bringen, in denen erwartet wird, dass eingebettete KI dominieren wird.

Wenn Sie neue IoT-Produkte, Robotik, Automobilprodukte oder andere Systeme bauen, die eingebettete KI-Fähigkeiten benötigen, achten Sie auf neuere KI-spezialisierte ICs mit einigen der folgenden Funktionen:

- Training auf dem Gerät: Dieser Aspekt der eingebetteten KI ist immer noch auf die Rechenleistung der Cloud angewiesen, aber die besten KI-spezialisierten ICs ermöglichen ein Training auf dem Gerät, z. B. in Anwendungen des überwachten Lernens.

- Schnelle Schnittstellen: Offensichtlich müssen KI-spezialisierte ICs mit anderen Komponenten auf einer Platine verbunden werden, und sie werden einige schnelle Schnittstelle verwenden. I2C und SPI sind ideale Schnittstellen, obwohl ich erwarten würde, dass auch andere schnelle Schnittstellen verwendet werden, um eine Verbindung mit Computerperipheriegeräten herzustellen.

- Optimierung für spezifische KI-Modelle: KI/ML-Modelle beinhalten redundante Matrixberechnungen und Optimierungsschritte, und die Hardwarearchitektur wird so konzipiert sein, dass sie die Algorithmen ausführt, die in verschiedenen KI/ML-Modellen involviert sind. Niedriger Stromverbrauch: Das Erreichen von Stromniveaus unterhalb von sub-mW für KI-Berechnungen ist entscheidend für anhaltendes Training, Klassifizierung und Vorhersage in datenintensiven KI-Anwendungen. Eine optimierte Architektur kann Designern helfen, den Hitzeengpass zu überwinden, was auch die Gesamtgröße eines neuen Produkts reduziert.

Vollkreis: Zurück zum Datenzentrum

Ich erwarte, dass in den nächsten Jahren neue spezialisierte ICs und IP-Cores weit verbreitet veröffentlicht werden. Diese Abkehr von der allgemeinen Datenverarbeitung hin zu anwendungsspezifischer Hardware ist es, was fortgeschrittenere eingebettete KI-Anwendungen ermöglichen wird. OEMs werden in der Lage sein, kleinere Geräte mit größerer Rechenleistung zu produzieren, als dies mit allgemeinen MCUs möglich wäre.

Ich habe über eingebettete KI auf der Edge-Ebene gesprochen, aber auf KI spezialisierte ICs können leicht wieder in die Netzwerkhierarchie bis zum Datenzentrum hochgefiltert werden. Das Auslagern dieser Aufgaben von allgemeinen Prozessoren auf einen ASIC wird den Gesamtenergieverbrauch auf der Ebene des Datenzentrums reduzieren.

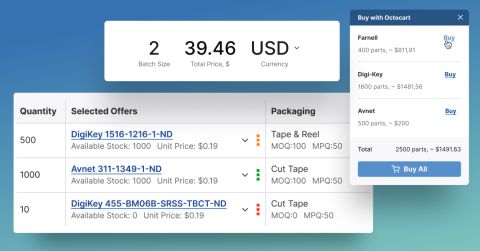

Die Landschaft der Elektronik kann sich schnell ändern, und eingebettete KI ist keine Ausnahme. Ob Sie die neuesten eingebetteten KI-ASICs oder irgendeine andere Komponente für ein neues Produkt suchen, Octopart wird hier sein, um Ihnen zu helfen, die benötigten Komponenten zu finden.

Bleiben Sie auf dem Laufenden mit unseren neuesten Artikeln, indem Sie sich für unseren Newsletter anmelden.