Jugada Maestra: Diseñando con Éxito Sistemas de Distribución de Energía

En la industria, el elemento de diseño que continúa causando más problemas es el sistema de entrega de energía (PDS, por sus siglas en inglés). Y, como firma consultora, durante los últimos años, la mayoría de los problemas para los cuales hemos sido llamados a resolver siempre han estado centrados en problemas del PDS. Como se señaló en mi blog anterior sobre las trazas de guarda y su ineficacia, cada vez que hemos sido convocados para resolver un problema de EMI, siempre hemos terminado arreglando el PDS.

Este artículo discutirá la evolución de los desafíos de diseño del PDS, cómo surgieron y los métodos utilizados para mitigarlos. La segunda parte de este artículo aborda el diseño del PDS para implementaciones de ultra bajo consumo.

Un Poco de Historia y Muchos Problemas

Primero, algo de base: todos los PDS tienen tanto inductancia (expresada como Lp) como resistencia (expresada como Rp) en serie por donde fluye la energía. A corrientes bajas, la resistencia no te molesta. A frecuencias bajas, la inductancia tampoco. Tan pronto como comienzas a aumentar en frecuencia, la inductancia se convierte en una fuente importante de degradación.

Entonces, retrocedamos un poco para ver cuándo cosas como la inductancia y la resistencia se convirtieron en problemas de preocupación. Más importante aún, podemos ver dónde entró en juego la "magia negra" del diseño de PDS.

Cuando comenzamos a usar placas de dos caras, los tiempos de subida de las señales en ellas eran a veces de decenas de nanosegundos. El contenido de frecuencia era realmente bajo y, como resultado, las pistas en las placas no causaban un problema. Toda la potencia se distribuía con pistas, no con planos. Podías colocar un capacitor a través de la ruta de cada CI, entre +5 y tierra en cada CI, y eso era suficiente. Luego, la tecnología ECL (lógica acoplada por emisor) apareció en escena.

La tecnología ECL nunca podría funcionar sin planos en las placas porque los tiempos de subida eran de menos de un nanosegundo. Aquí es donde el uso de pistas para la distribución de potencia se volvió inaceptable. Debido a los rápidos tiempos de subida, simplemente no podías conectar la potencia con pistas. Había demasiada inductancia. Así que, desde el mismo inicio de la tecnología ECL siempre hubo un par de planos de potencia. Los ingenieros que usaban la tecnología ECL en sus diseños entendieron esto y utilizaron planos de potencia.

Ahora, pasemos a la lógica TTL (transistor a transistor). Con la TTL básica, podrías distribuir la energía con pistas. Luego llegó la aparición de ASTTL (TTL Schottky Avanzado). Era tan rápido como el ECL, pero los ingenieros que diseñaban productos con él intentaron usar los mismos métodos que usaban con la TTL lenta y los circuitos no eran estables. El resultado fue un temible EMI (interferencia electromagnética). La gente intentó usar capacitores de .1 y .01 microfaradios y no funcionó. Y, fue entonces cuando todas las reglas de "magia negra" empezaron a aparecer.

Prácticamente no había ingenieros de EMI en el dominio público, y debido a que los ingenieros que usaban TTL no entendían cosas como líneas de transmisión, entrega de energía y el enrutamiento de señales rápidas, se metieron en problemas reales. Un producto podría fallar en un campo de prueba de EMI y el ingeniero de diseño preguntaría a la persona que realizaba la prueba qué se debería hacer al respecto y el ingeniero de pruebas (que no entendía el diseño de PDS) citaría algo que alguien más hizo para mejorar el problema y se anotaría en una lista y se pasaría alrededor. Estas listas fueron el génesis de las reglas de "magia negra".

El papel de los capacitores en el diseño de PDS y más allá

Uno de los resultados de las reglas de la "magia negra" fue que, cuando llegaba el momento de diseñar un PDS, las personas tendían a colocar muchos capacitores en sus placas en un intento de solucionar problemas de PDS sin realmente entender cómo funcionaban o no esos capacitores. De aquí surge la noción de capacitores de desacoplamiento. En realidad, estos capacitores no desacoplan nada. En cambio, proporcionan una fuente local de carga para soportar un evento de conmutación.

Se les denomina mejor como "cubos de coulomb" ya que almacenan coulombs de carga utilizados para soportar eventos de conmutación. (Un coulomb es la unidad de carga eléctrica del Sistema Internacional de Unidades. Es la carga transportada por una corriente constante de un amperio en un segundo). Si los capacitores utilizados no son del tamaño adecuado o no funcionan en las frecuencias involucradas, el resultado es un rizado en Vdd. (Vdd es el terminal de la fuente de alimentación que se conecta al extremo de drenaje de un transistor o IC MOS o CMOS. Comúnmente es el riel más positivo de la fuente de alimentación). Un tratamiento exhaustivo de este tema aparece en el artículo de Lee Ritchey en Altium Resource, "Ganar en el diseño del sistema de entrega de energía", publicado el 17 de enero de 2019).

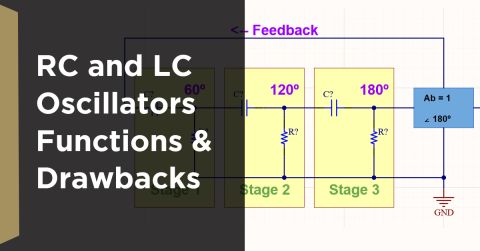

En 1995, la facultad de EMC de la Universidad de Missouri, Rolla, (ahora la Universidad de Ciencia y Tecnología de Missouri) demostró cómo el uso clásico de capacitores para eludir el PDS no era efectivo para resolver problemas de EMI (ver Referencia 2). (Una alta impedancia significa alto rizado y potencial EMI.) La Figura 1 muestra tres curvas de impedancia vs. frecuencia resultantes de ese estudio.

Figura 1. Impedancia del PDS vs Frecuencia del Papel de UMR

Figura 1. Impedancia del PDS vs Frecuencia del Papel de UMR

Gráfico cortesía de IEEE y Todd Hubing

En esencia, los capacitores de .1 y .01 microfaradios mejoraron el rendimiento del sistema de alimentación (redujeron su impedancia) hasta aproximadamente 70MHZ. A partir de 70MHZ, empeoran la impedancia y luego eventualmente no hacen nada en absoluto. Específicamente, es la inductancia parásita en serie con los capacitores lo que los hace inútiles después de cierta frecuencia. Lo que este estudio mostró fue que la única manera de controlar la impedancia a altas frecuencias (por encima de 100MHZ) es usar la capacitancia de plano. La cantidad de capacitancia necesaria se puede determinar al establecer el número de líneas de transmisión que necesitan ser impulsadas al mismo tiempo. En las líneas de transmisión de conmutación, la carga se transfiere de la fuente de alimentación a la línea de transmisión. A partir de esto, se puede determinar qué tan grande tiene que ser el dispositivo de almacenamiento de carga (o cubo de coulomb).

Por lo tanto, para tener una operación estable y sin EMI, debe haber un PDS realmente robusto. En este caso, robusto significa suministrar corriente a frecuencias muy altas (por encima de 100MHZ) y eso solo se puede lograr con la capacitancia de plano. Una forma obvia de crear capacitancia de plano en un PCB es agregar dos capas de plano para ese propósito. Estas capas de plano pueden ser un material especial como ZBC de Sanmina u otros materiales desarrollados para este propósito. Alternativamente, cuando un PCB tiene varios planos, pueden organizarse de tal manera que pares de planos estén uno frente al otro a través de una pieza de laminado o prepreg. Cualquiera de los métodos logra los resultados deseados. La ventaja de colocar capas de plano una al lado de la otra en lugar de usar un material especial como ZBC es que no se agrega un precio premium al costo del PCB como resultado de usar el material especial.

Pero, ¿qué haces cuando tienes placas pequeñas, como las placas de cuatro capas en un Xbox, donde no hay suficiente espacio en la placa para tener capacitancia de plano? La única solución es trasladar la capacitancia de alta calidad al paquete del IC y al propio die. Durante décadas, compañías como AMD e Intel han estado incorporando capacitancia en sus componentes porque la mayoría de sus piezas se montaban en placas de cuatro capas. Pero, hasta hace siete u ocho años, los proveedores de FPGA no incorporaban capacitancia en sus componentes. Esto llevó a que se construyeran varias placas que fallaron. En algunos casos, las empresas tuvieron que rediseñar completamente sus productos, lo que resultó en la pérdida de ventanas de lanzamiento de productos y altos costos de NRE. En otros casos, aquellas empresas que no podían permitirse rediseños o perdieron completamente las ventanas de mercado simplemente cerraron. Afortunadamente, ahora, todos los principales proveedores de FPGA "lo entienden" y han incorporado capacitancia en sus componentes.

El próximo gran desafío han sido todos los ICs que tienen mil millones de transistores y requieren 100 amperios a .9 voltios. Por lo tanto, el desafío ha sido entregar corrientes muy altas a voltajes muy bajos donde no hay mucha tolerancia para la caída de voltaje. Esto significa que la necesidad de abordar la resistencia volvió a entrar en escena. Esto se ha logrado reduciendo el número de capas de señal en un apilamiento y reemplazándolas con planos de tierra adicionales. Por ejemplo, en una placa de 22 capas construida para un producto de monitoreo de red de alta velocidad, las cuatro capas centrales se convirtieron en planos de tierra y Vdd de una onza colocados en paralelo.

Pero, ahora, incluso cambiar el apilamiento no es suficiente. Más allá de mirar el voltaje terminal en la salida de la fuente de alimentación, hay una necesidad de compensar la caída de voltaje que ocurre después de eso. Para estas corrientes muy altas, hay dos líneas de sentido que son parte de un bucle de retroalimentación. Una línea va al terminal de tierra y la otra va al terminal Vdd. Estas líneas de sentido no están conectadas en la salida de la fuente de alimentación. En su lugar, se llevan a través de un par de pines dedicados en

el Vdd y la tierra dentro del paquete del CI de modo que el voltaje se sienta en el silicio en lugar de en la placa. Quien diseña el CI debe proporcionar un único pin que esté aislado de los planos de Vdd y tierra en el paquete. Un proveedor se refiere a ellos como "agujeros de mira" porque te permiten entrar y medir lo que sucede en el dado.

Hoy en día, no es raro tener dos o tres mil millones de transistores en un chip. El objetivo ahora no es sobre amontonar más transistores en un chip, sino hacerlos más rápidos. Esta es la tecnología FinFET donde un MOSFET se construye sobre un sustrato donde la puerta se coloca en dos, tres o cuatro lados del canal o se envuelve alrededor del canal formando una estructura de puerta doble. En esta arquitectura, tienes puertas muy estrechas de 14nm y el canal se levanta por dos lados. Así es como los fabricantes de chips logran estas dimensiones tan diminutas. Esta es también la razón por la cual el voltaje tiene que caer porque los grosores de óxido son tales que no pueden tolerar voltajes muy altos y hay una ruptura entre la fuente y el drenaje. Esta es la tecnología que está impulsando 56Gbps—muchos transistores en dimensiones muy pequeñas con capas de óxido muy delgadas. Todo se trata del rendimiento y de hacer que las cosas cambien más rápido.

Resumen

A lo largo de la historia de los diseños de PDS, pasamos de no tener que preocuparnos por la resistencia o la inductancia, a tener que preocuparnos por la resistencia y luego por la inductancia, y ahora tenemos que preocuparnos de nuevo por la resistencia. El enfoque de pin-en-chip aborda la resistencia y los fabricantes de chips han estado proporcionando eso durante los últimos siete u ocho años. Saben que tienen que asumir los problemas de PDS dentro del paquete. Sin embargo, como con la mayoría de los aspectos de nuestra tecnología, es una buena idea pedir a los proveedores de IC que proporcionen una placa de demostración que muestre cómo funciona el IC de la manera que lo necesitas antes de comprometer el silicio a tu placa.

Referencia

1. Ritchey, Lee W. y Zasio, John J., “Right The First Time, A Practical Handbook on High-Speed PCB and System Design, Volumes 1 and 2.” 2. Hubing, Todd, etal, “PWB Power Structures: Theory and Design,” Universidad de Missouri, Rolla, noviembre de 1999.

¿Te gustaría saber más sobre cómo Altium puede ayudarte con tu próximo diseño de PCB? Habla con un experto en Altium.