CCD vs. CMOS-Sensor Vergleich: Welcher ist besser für die Bildgebung?

Sollten Sie in dieser Kamera einen CCD- oder CMOS-Sensor verwenden? Hier erfahren Sie, wie Sie diese Sensoren vergleichen können.

Jedes Design für Bildgebung, Computer Vision und Photonik-Anwendungen benötigt eine Art von optischer Baugruppe und Sensor, um ordnungsgemäß zu funktionieren. Ihr nächstes optisches System wird eine breite Palette von optischen Komponenten integrieren, und Bildsensoren sind die Brücke zwischen der optischen und elektronischen Welt.

Eine kluge Sensorauswahl erfordert die Berücksichtigung einer Reihe von Faktoren. Einige dieser Faktoren beziehen sich auf Reaktionszeit, Formfaktor, Auflösung und Anwendung. Die Wahl zwischen einem CCD- und CMOS-Sensor kann schwierig sein, aber sie wird bestimmen, wie schnell Ihr System Bilder auflösen kann, während eine Sättigung vermieden wird. Wenn Sie außerhalb des sichtbaren Bereichs arbeiten müssen, müssen Sie alternative Materialien zu Si für eine effektive Bildgebung in Betracht ziehen. In einigen Anwendungen kann es sinnvoller sein, mit einem Photodioden-Array zu arbeiten. Hier erfahren Sie, was Sie über diese verschiedenen Arten von Sensoren wissen müssen und wie Sie die richtige Komponente für Ihre Anwendung auswählen.

Bildsensor- und Systemanforderungen

Jedes Bildgebungssystem sollte so konzipiert sein, dass es bestimmte Anforderungen erfüllt, und viele davon konzentrieren sich auf die Wahl des optischen Sensors. Um zu beginnen, sollten Sie das Material, das Sie für Ihren Wellenlängenbereich benötigen, in Betracht ziehen und dann Aspekte wie Auflösung, Reaktionszeit und Linearität vergleichen.

Aktives Material und Erfassungsbereich

Das aktive Material, das in Ihrem Sensor verwendet wird, bestimmt den empfindlichen Wellenlängenbereich, Bandtail-Verluste und Temperatur-Empfindlichkeit. Je nach Anwendung arbeiten Sie möglicherweise im Infrarot-, sichtbaren oder UV-Bereich. Für Kamerasysteme möchten Sie eine Empfindlichkeit im gesamten sichtbaren Bereich, es sei denn, Sie arbeiten an einem Wärmebildsystem. Für spezialisierte Bildgebungsanwendungen, wie z.B. Fluoreszenzbildgebung, arbeiten Sie möglicherweise irgendwo im Bereich von IR bis UV.

Einige aktive Materialien befinden sich noch in der Forschungsphase, während einige als kommerzialisierte Komponenten leicht verfügbar sind. Wenn Sie CCD- vs. CMOS-Sensorkomponenten vergleichen, ist das aktive Material ein guter Ausgangspunkt bei der Auswahl von Kandidatensensoren.

- Si: Dies ist das am häufigsten verwendete Material in Bildsensoren. Seine indirekte Bandlücke von 1,1 eV (~1100 nm Absorptionskante) macht es am besten geeignet für sichtbare und NIR-Wellenlängen.

- InGaAs: Dieses III-V-Material bietet IR-Detektion bis zu ~2600 nm. Seine niedrige Sperrschichtkapazität von <1 nF macht InGaAs-Sensoren ideal für Anwendungen bei SMF-Wellenlängen (1310 und 1550 nm). Die Abstimmung wird durch Ändern der Stöchiometrie von In(1-x)GaxAs erreicht. InGaAs CCD-Sensoren sind auf dem Markt von Photonik-Lieferanten erhältlich, und Unternehmen wie IBM haben die Kompatibilität von InGaAs mit CMOS-Prozessen demonstriert.

- Ge: Dieses Material ist in CCD-Kameras und Sensoren weniger verbreitet aufgrund seiner höheren Kosten als Si, und alle Ge- und SiGe-CMOS-Sensoren sind nach wie vor ein heißes Forschungsthema.

Es gibt auch andere Materialien, die als Bildsensoren verwendet werden können, obwohl diese normalerweise in Photodioden eingesetzt werden und nicht stark kommerzialisiert sind. Wenn Sie im sichtbaren Bereich arbeiten, ist Si der Weg, den Sie einschlagen sollten, da Sie Empfindlichkeit bei Wellenlängen von ~400 nm bis ~1050 nm haben werden. Wenn Sie tief im IR-Bereich arbeiten, sollten Sie InGaAs verwenden. Si CCD- und CMOS-Sensoren können für UV-Wellenlängen verwendet werden, aber nur, wenn der Sensor eine spezielle Oberflächenbehandlung hat, um Ablation zu verhindern.

Farbfilter werden oft auf CCD- und CMOS-Sensoren verwendet, um monochrome Bilder zu erzeugen oder spezifische Wellenlängen zu filtern. Es ist üblich, CCDs und CMOS-Sensoren mit einem scharfen Glasfilter oder einer dünnen Schicht zu sehen, um IR-Wellenlängen zu entfernen.

Bildrate, Auflösung und Rauschen

Die Bildrate wird durch die Art und Weise bestimmt, wie Daten vom Detektor ausgelesen werden. Der Detektor besteht aus diskreten Pixeln, und die Daten müssen sequenziell aus den Pixeln gelesen werden. Die Methode zum Auslesen der Pixel bestimmt die Geschwindigkeit, mit der Bilder oder Messungen erfasst werden können. CMOS-Sensoren verwenden ein Adressierungsschema, bei dem der Sensor und jedes Pixel einzeln gelesen wird. Im Gegensatz dazu verwenden CCDs eine globale Belichtung und lesen jede Spalte von Pixeln mit einem Paar Schieberegistern und einem ADC aus.

Da diese Sensoren unterschiedliche Methoden für das Auslesen verwenden, benötigen verschiedene Sensormodule unterschiedliche integrierte Komponenten. Hier beginnt der eigentliche Vergleich, da die integrierte Elektronik Rauschzahlen, Linearität, Empfindlichkeit, Farbtiefe (Anzahl der Farben, die reproduziert werden können) und Nachweisgrenze bestimmen wird. Die untenstehende Tabelle zeigt einen kurzen Vergleich der wichtigen Bildgebungsmerkmale für CCD- und CMOS-Sensoren.

| | CCD | CMOS | | ---------- | ---------- | ---------- | | Auflösung | Bis zu 100+ Megapixel | Bis zu 100+ Megapixel | | Bildrate | Am besten für niedrigere Bildraten | Am besten für höhere Bildraten | | Rauschzahl | Niedrigeres Rauschen → Höhere Bildqualität | Höheres Rauschen → Niedrigere Bildqualität | | Empfindlichkeit und Linearität | Niedrigere Empfindlichkeit, breiterer linearer Bereich | Höhere Empfindlichkeit, niedrigerer linearer Bereich (sättigt früh) | | Nachweisgrenze | Niedrig (empfindlicher bei geringer Intensität) | Hoch (weniger empfindlich bei geringer Intensität) | | Farbtiefe | Höher (16+ Bits sind typisch für teure CCDs) | Niedriger, obwohl sie den CCDs vergleichbar wird (12-16 Bits sind typisch) |

Was ist mit Photodioden?

Dies ist eine berechtigte Frage, da Photodioden-Arrays ebenfalls verwendet werden können, um 1D- oder 2D-Intensitätsmessungen zu sammeln. Es ist wichtig zu beachten, dass eine Photodiode das aktive Element in einem CCD- oder CMOS-Sensor ist; die drei Sensortypen unterscheiden sich in der Art und Weise, wie Daten aus dem Gerät ausgelesen werden. Ein Photodioden-Array wird mit einer gemeinsamen Kathodenkonfiguration konstruiert, sodass Daten parallel aus dem Gerät ausgelesen werden. Dies macht Photodioden schneller als CCDs und CMOS-Sensoren. Allerdings bedeutet die Verwendung von zwei Drähten pro Photodiode, dass Sie eine kleine Anzahl von Photodioden in einem Array haben werden; eine 100x100 Pixel Photodiode hätte 20.000 elektrische Leitungen. Man kann sehen, wie dies schnell unpraktisch wird.

Die andere Option für die Verwendung von Photodioden besteht darin, das Sichtfeld mechanisch mit einer Laserdiode zu raster-scannen und reflektiertes/zerstreutes Licht zu sammeln. Dieser Punkt-Messansatz wird in UAV- und automobilen Lidar-Systemen verwendet. Auf diese Weise können Sie ein Bild mit niedriger Auflösung erstellen, wobei die Bildrate durch die Scanrate und die Mittelungszeit begrenzt ist. In dieser Anwendung gewinnen CCD- und CMOS-Sensoren immer noch dank ihrer höheren Auflösung und ähnlichen Bildraten.

Beispiel eines raster-gescannten Lidar-Bildes für ein autonomes Fahrzeug. Beachten Sie den Bus auf der rechten Seite des Bildes. Bildnachweis: Baraja.

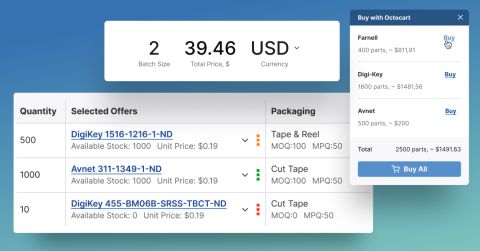

Das Finden und Überprüfen von CCD- vs. CMOS-Sensorarrays sind kritische Schritte im Design von Bildgebungssystemen. Sie können diese Komponenten und viele mehr auf Octopart finden.

Bleiben Sie auf dem Laufenden mit unseren neuesten Artikeln, indem Sie sich für unseren Newsletter anmelden.

Back

Back